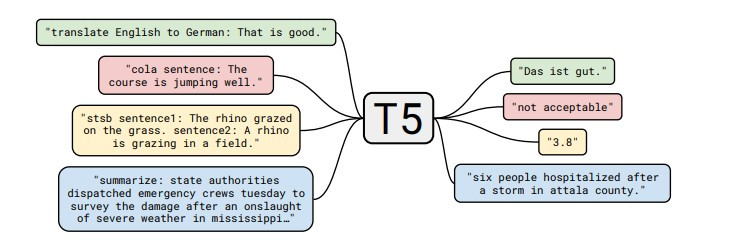

深度神經網路(Deep Neural Network)

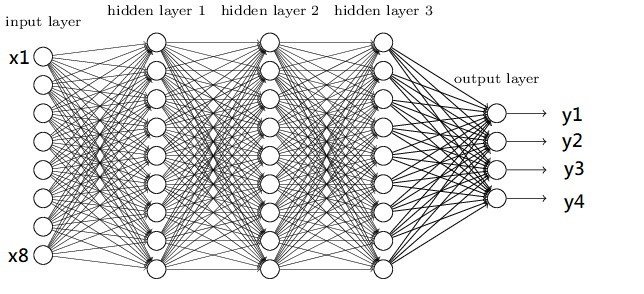

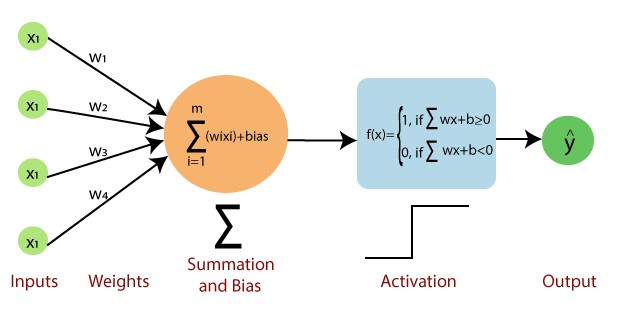

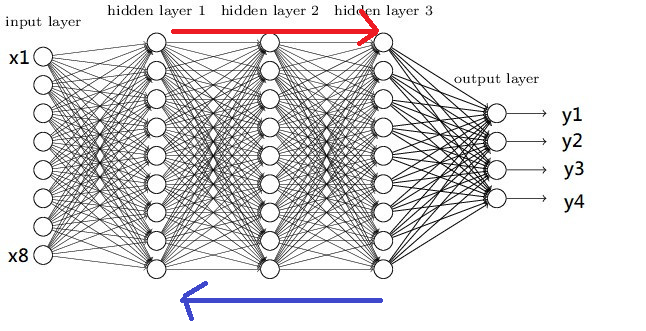

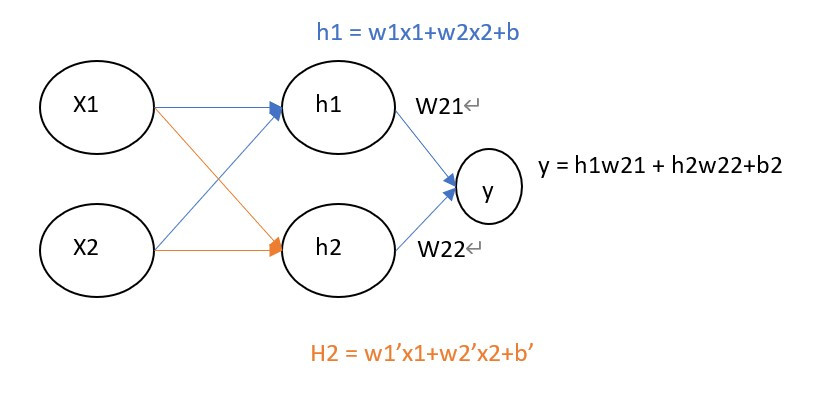

在開始寫程式前,先來看一下最基礎的神經網路DNN的架構圖

圖片來源:https://www.researchgate.net/figure/Deep-Neural-Network-DNN-example_fig2_341037496

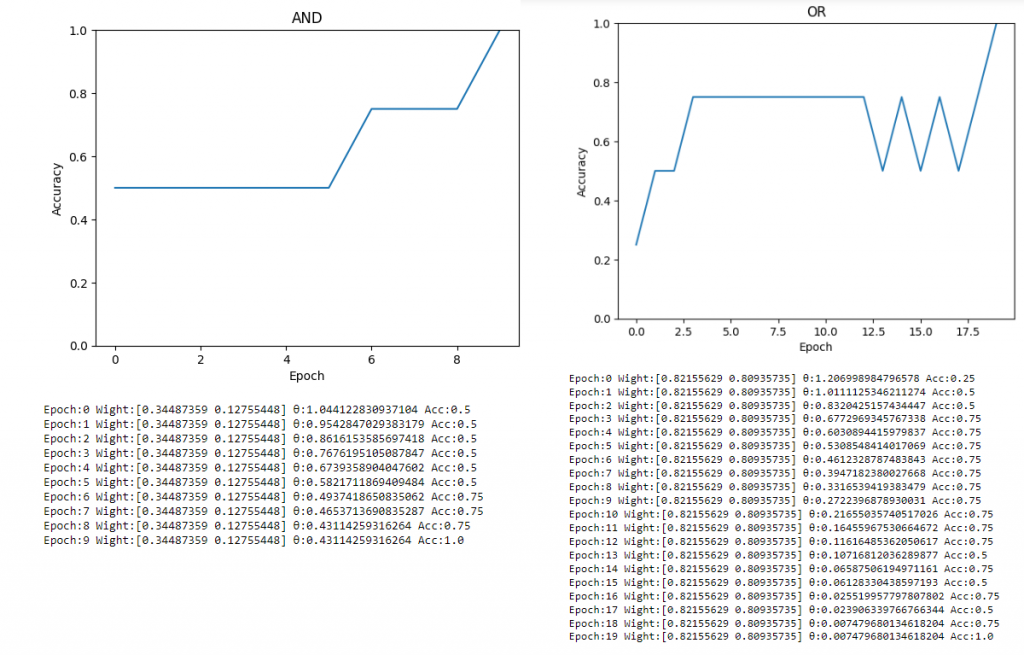

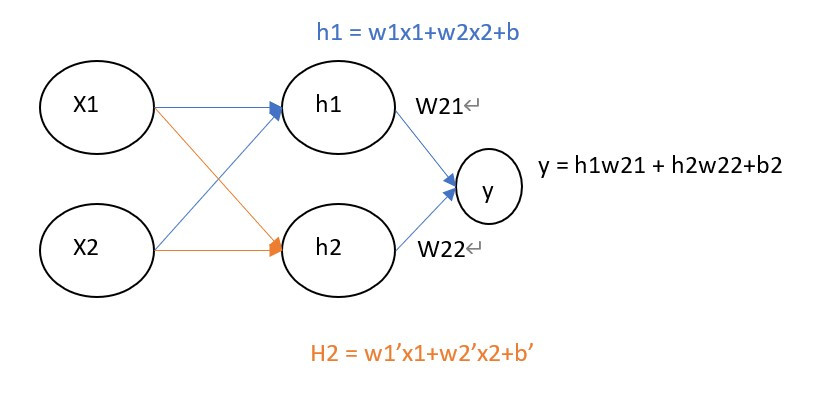

圖片是不是看起來有點複雜,其實概念很的簡單,假設我們有個資料集要辨識4種類型得圖片y1~y4,每張圖片有8個特徵(Feature)x1~x8,那神經網路所扮演的角色就是訓練權重(weight)w1~w8,我們可以把權重當作是每一個特徵的分數,分數越高的結果,代表可能性越大,像是在架構圖中的圖片中我們可以用公式能表達為y = x1w1+x2w2+x3w3+x4w4+x5w5+x6w6+x7w7+x8w8,找到最高分數的y就是可能性最高的結果。

這樣是不是有一些概念了,接下來開始講解輸入層(input layer)、隱藏層(hidden layer)、輸出層(output layer)的概念。

輸入層(input layer)

神經網路的第一層被稱作輸入層,這層取得在外部的資源,像是圖片、文字、音訊、能被接受到的訊息,在這層中不會有任何的公式運算,只是傳送資料至下一層。

隱藏層(hidden layer)

隱藏層是在訓練中最重要的一個環節,神經網路就是在這層中學習特徵並產生權重的,一個神經網路至少要有一層隱藏層。

輸出層(output layer)

隱藏層會將資料丟給輸出層,這層的輸出大小會根據你所想要的任務而不同,像是辨識貓與狗的圖片(分類任務)輸出層就會是2(只有貓跟狗),若像是股票預測(回歸)輸出則為1。

看完以上的敘述後,有沒有發現一個問題,輸出是x1w1+...x8w8那不就會是線性了嗎?為瞭解決這個問題於是有了激勵函數(activation function),它能夠使神經網路變成非線性,比較常見的激勵函數有:relu、tanh、softmax、sigmoid等激勵函數,這些函數選用與解說我會在後續的實作課程中講解,這邊先有個概念就好。

建立環境

還記得第一天教的如何安裝函式庫嗎?

今天會用到的函式庫如下:

numpy:支援高階大量的維度陣列與矩陣運算,也針對陣列運算提供大量的數學函數函式庫

tensorflow:深度學習函式庫,在今天只會做為keras的後端並不會實際用到

keras:能夠串接tensorflow,使其能夠簡易的建立神經網路

jupyter:Web的互動式計算環境

那麼我們就開始使用pip安裝這些函式庫吧!!

pip install tensorflow==2.3.0

pip install keras==2.3.1

pip install jupyter

開啟jupyter notebook

安裝函式庫後,該怎麼開始深度學習的第一支程式呢?

在這邊我會建議先創立一個資料夾,避免資料會混亂,我們先將資料夾命名為"mnist手寫辨識"。

點進去資料夾裡面後按下ALT+D就會就會自動跳到網址列,我們只需要在網址列中輸入cmd。

接下來我們在cmd當中輸入jupyter notebook(注意開啟後cmd不能關掉)。

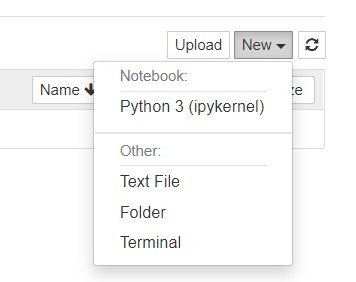

開啟jupyter後點擊右上角的new選擇python3創立檔案。

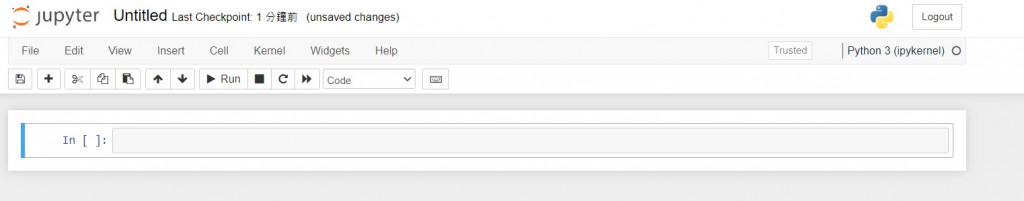

看到這個頁面就代表可以開始寫程式啦~

呼叫函式庫

首先我們要來學習如何呼叫函式庫

當我們想使用一個函式庫時只需用

import XXX(函示庫名稱)

像是要使用numpy,就能寫成

import numpy

之後就能使用功能了,例如將list轉換成array只需要在函式庫的名稱後面加入.就能使用function

list = [1,2,3]

list = numpy.array(list)

但如果今天覺得numpy這個名字太長了就能用以下的寫法

#import 函示庫 as 簡化的名稱

import numpy as np

list = [1,2,3]

list = np.array(list)

但這樣子import會把函式庫裡面的function通通放到程式裡出來,所以為了節省空間會將一些較常使用的function單獨呼叫

#from 函示庫 import 功能 as 簡化名稱

from numpy import array as ar

list = [1,2,3]

list = ar(list)

這就是在python呼叫函式庫的辦法,瞭解之後就開始進入今天的正題的MNIST手寫辨識吧!!

MNIST手寫辨識實作

在這邊我們先將程式分為幾個部分: 1.導入函式庫 2.資料前處理 3.模型的建構 4.模型的訓練

1.導入函式庫

import numpy as np

import tensorflow.keras

from tensorflow.keras.datasets import mnist

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Activation

from tensorflow.keras.utils import to_categorical

函式庫說明:

1.keras.datasets:包含著一些著名的資料集例如:nmist、IMDB影評

2.keras.models:架構神經網路

3.keras.layers:創建神經網路Dense(DNN)、conv2d(CNN)

4.keras.utils:資料正規化

2.資料前處理(Data Preprocessing)

在資料前處理之前我們先讀取mnist的資料。

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train, x_test : uint8 數組表示的灰度圖像,尺寸為(num_samples, 28, 28)。 y_train, y_test : uint8 數組表示的數字標籤(範圍在0-9 之間的整數),尺寸為(num_samples,)。

拿到資料後先來看一下資料的shape

print(x_train.shape)

------顯示------

(60000, 28, 28)

第一碼60000代表的是資料大小,總共有60000張圖片 第二碼則是長有28個pixel 第三碼則是寬有28個pixel

我們先回到一開始的架構圖,有沒有發現他的輸入是一整排的(一維),而我們的資料卻是二維,所以要將28x28(2維)的資料變成784(1維)的資料,在這裡我們是用reshape這個function重新list的大小。

x_train = x_train.reshape(60000, 784)

x_test = x_test.reshape(10000, 784)

------顯示------

(60000, 784)

現在來觀看一下第一筆訓練資料的內容

print(x_train[0])

------顯示------

[.... 18 18 18 126 136 175 26 166 255 ...0 0 0 0 0 0 0 0 0]

可以看到裡面有許多數值,這數值代表的是顏色越靠近0的是白色,越靠近255則是黑色,這也就是我們圖片的特徵值。

但是在神經網路中數值越大收斂越慢,且會受到極端值的影響,使訓練效果不佳,所以在這邊將數值除255讓數值能夠壓縮在0~1之間

x_train = x_train/255

x_test = x_test/255

這樣就處理完放入model的圖片資料了。

為了知道神經網路的準確率,我們需要給圖片一個標籤(Label),但是機器只會看懂0跟1,所以我們需要把數字正規化,在這邊使用one-hot-encoding作為正規化的方式。

y_train = to_categorical(y_train)

y_test = to_categorical(y_test)

假設的label裡面有1與2,那one-hot-encoding就會以位置表達數字的涵義

例如:label = [1,2] 那1就會被編譯成[1,0]、2就會被編譯成[0,1]

到這邊我們就完成圖片與標籤的資料前處理了

3.模型的建構

首先說明一下在本次訓練內用到的激勵函數relu與softmax。

relu:會將0以下的數值通通當作是0,這能夠加強資料的特徵,同時還能加速程式收斂的速度,通常會用於CNN、DNN等架構上。

softmax:會將數值歸一化,且輸出向量中擁有最大權重的項對應著輸入向量中的最大值,通常會定義在分類任務的輸出層。

# 建立模型

model = Sequential()

# 輸入層與隱藏層

model.add(Dense(units=256,input_dim=784, activation='relu'))

# 隱藏層

model.add(Dense(units=128, activation='relu'))

# 輸出層

model.add(Dense(units=10,activation='softmax'))

用keras建立模型相當的簡單,只需要將Sequential()宣告給一個變數後就能使用add就能加入層數,程式碼的範例是一個784大小的輸入層,並且有兩層隱藏層大小分別維256與128,最後輸出10個結果(辨識0~9)。

4.模型的訓練

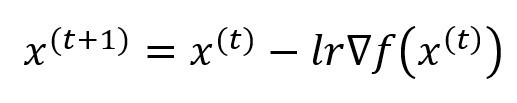

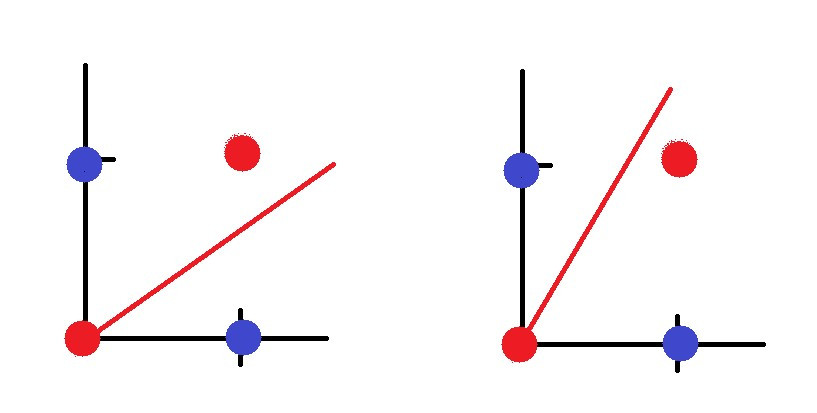

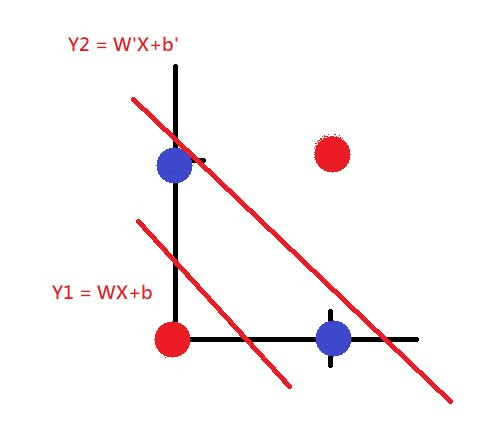

建立模型之後當然是訓練它了,在訓練之前我們要先了解損失函數(Loss Function)與優化器(Optimizer)。

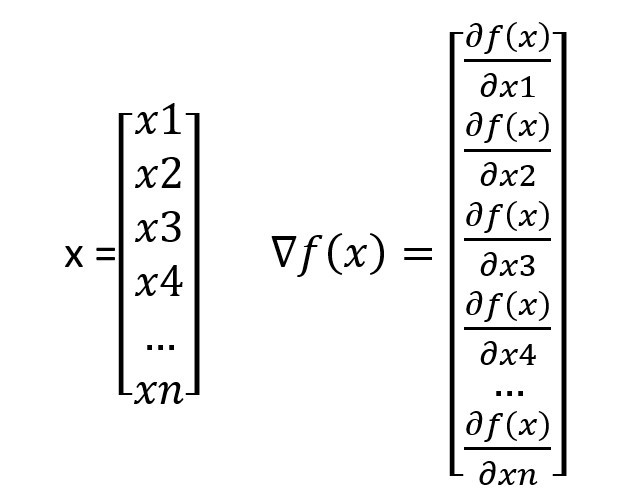

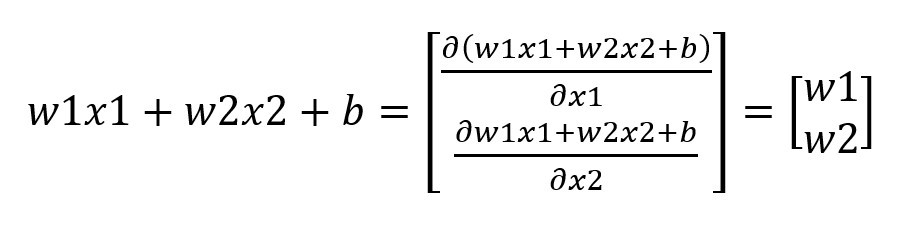

優化器(Optimizer):我們在國中應該都學過就是微積分找極值,而在深度學習中就是改良找極值的方式去做到最佳化的,我們叫這種方式為梯度下降(Gradient Descent)而這概念則與滑板場相同。想像今天有一個U型滑板場,只要沒有加速最終就會停留在U型的最底部,但若是W型的滑板場就不一定會找到低點了,我們可以想最深的坑會有最陡的坡,所以我們只要給予滑板一定的動力就能一路滑到最深的坑裡爬不出來,而這個名詞就叫做學習率(Learn Rate),若學習率太高(動力太大)就會找不到最低點,若是動力太小找到最低點則會非常的緩慢,所以就會使用一些偷吃步找到最低點,在深度學習中的偷吃步就是optimizer,可以利用不同optimizer來找的最合適的梯度下降法。

損失函數(Loss Function):一個模型學到特徵的好壞,最關鍵的點就是損失函數的設計,在keras中基本上只會使用到兩個:分類任務常用的categorical_crossentropy,以及回歸任務常用的MSE,當然這些都會是一定的,現階段只會會用就可以了。

# 宣告loss finction與optimizer

model.compile(loss='categorical_crossentropy',optimizer='adam',metrics=['accuracy'])

# 開始訓練model batch_size一次丟多少資料進去訓練 epochs總共要訓練幾次

history = model.fit(x_train, y_train,

batch_size=128,

epochs=10,

verbose=1,

validation_data=(x_test, y_test))

#結果

Epoch 1/10

469/469 [==============================] - 1s 2ms/step - loss: 0.2677 - accuracy: 0.9238 - val_loss: 0.1259 - val_accuracy: 0.9622

Epoch 2/10

469/469 [==============================] - 1s 2ms/step - loss: 0.1011 - accuracy: 0.9696 - val_loss: 0.0968 - val_accuracy: 0.9697

Epoch 3/10

469/469 [==============================] - 1s 2ms/step - loss: 0.0662 - accuracy: 0.9804 - val_loss: 0.0781 - val_accuracy: 0.9758

Epoch 4/10

469/469 [==============================] - 1s 2ms/step - loss: 0.0457 - accuracy: 0.9858 - val_loss: 0.0725 - val_accuracy: 0.9762

Epoch 5/10

469/469 [==============================] - 1s 2ms/step - loss: 0.0362 - accuracy: 0.9888 - val_loss: 0.0755 - val_accuracy: 0.9775

Epoch 6/10

469/469 [==============================] - 1s 2ms/step - loss: 0.0266 - accuracy: 0.9913 - val_loss: 0.0672 - val_accuracy: 0.9784

Epoch 7/10

469/469 [==============================] - 1s 2ms/step - loss: 0.0204 - accuracy: 0.9938 - val_loss: 0.0722 - val_accuracy: 0.9793

Epoch 8/10

469/469 [==============================] - 1s 2ms/step - loss: 0.0167 - accuracy: 0.9946 - val_loss: 0.0744 - val_accuracy: 0.9796

Epoch 9/10

469/469 [==============================] - 1s 2ms/step - loss: 0.0158 - accuracy: 0.9950 - val_loss: 0.0826 - val_accuracy: 0.9778

Epoch 10/10

469/469 [==============================] - 1s 2ms/step - loss: 0.0130 - accuracy: 0.9955 - val_loss: 0.0845 - val_accuracy: 0.9784

我們可以看到用DNN訓練手寫辨識已經97.84%的辨識率了,是不是很簡單呢? 明天就來教一下CNN的架構與程式,那我們明天再見!

完整程式碼

import tensorflow.keras

import numpy as np

from tensorflow.keras.datasets import mnist

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Activation

from tensorflow.keras.utils import to_categorical

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train = x_train.reshape(60000, 784)

x_test = x_test.reshape(10000, 784)

x_train = x_train/255

x_test = x_test/255

y_train = to_categorical(y_train)

y_test = to_categorical(y_test)

# 建立模型

model = Sequential()

# 輸入層與隱藏層

model.add(Dense(units=256,input_dim=784, activation='relu'))

# 隱藏層

model.add(Dense(units=128, activation='relu'))

# 輸出層

model.add(Dense(units=10,activation='softmax'))

model.compile(loss='categorical_crossentropy',optimizer='adam',metrics=['accuracy'])

history = model.fit(x_train, y_train,

batch_size=128,

epochs=10,

verbose=1,

validation_data=(x_test, y_test))

課程中的程式碼都能從我的github專案中看到 https://github.com/AUSTIN2526/learn-AI-in-30-days

找到圖片的特徵-捲積神經網路(Convolutional neural network)

卷積神經網路(Convolutional neural network)

經過昨天使用DNN辨識手寫圖片,有沒有發現再怎麼調整參數,準確率都上不去了呢?

這是因為DNN的演算法就只能有這樣的效果,那我們要怎麼提高準確率呢?

也就是今天的主題卷積神經網路(Convolutional neural network)

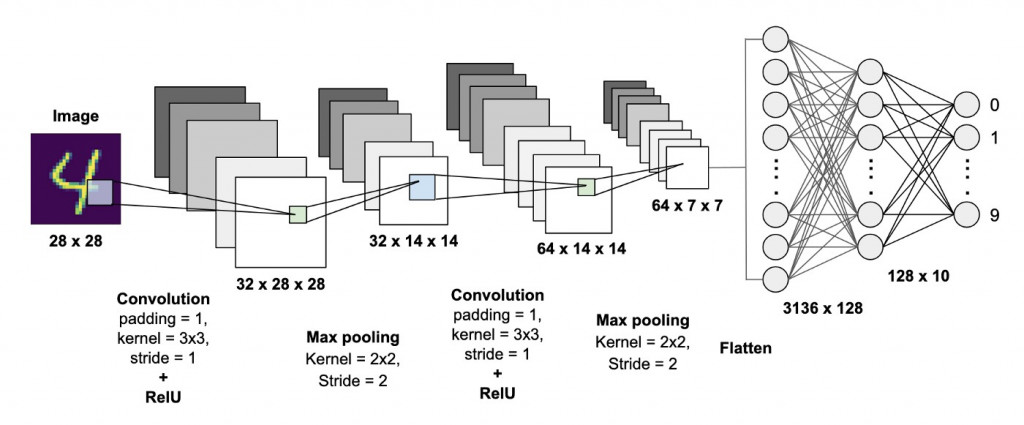

跟昨天一樣先放一張架構圖

圖片來源:https://becominghuman.ai/building-a-convolutional-neural-network-cnn-model-for-image-classification-116f77a7a236

看到圖片後有沒有注意到攤平(Flatten)後的部分,是不是與昨天學習到到DNN相同,那兩者差別在哪呢?答案就是CNN會通過捲積(Convolution)、池化(Pooling)等運算方式提取出更重要的特徵,通過攤平(Flatten)將特徵放入到全連接層(DNN也是種全連接神經網路)的架構當中,得到更好的輸出結果。

知道上述的概念之後,接下來開始更深入的介紹捲積層(Convolution Layer)、池化層(Pooling Layer)、全連接層(Fully Connected Layer)究竟是什麼。

捲積層(Convolution Layer)

捲基層的原理是利用卷積核(Kernel)通過步長(Stride)的滑動對圖像提取訊息,若超過圖片大小則會對其填充(Padding)補值,我們用例子來說明:

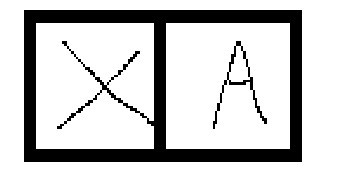

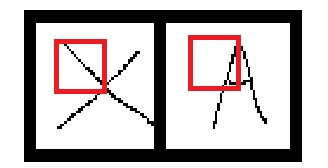

可以看到圖片中兩個英文單字X與A,那怎麼知道哪圖片是X又哪張圖片是A呢?

我們可以先畫個方框將圖片拆解

這時候就能用些較簡單的邏輯分辨出特徵,例如:X左上角的區塊是由左上到右下畫出來的,而A左上角的區塊則是右上往左下畫出來的。在圖片中的紅框處,它會先加總方框內的圖像數值之後與卷積核相乘,並通過步長移動方框的位置,產生出新的陣列。

這時候就能用些較簡單的邏輯分辨出特徵,例如:X左上角的區塊是由左上到右下畫出來的,而A左上角的區塊則是右上往左下畫出來的。在圖片中的紅框處,它會先加總方框內的圖像數值之後與卷積核相乘,並通過步長移動方框的位置,產生出新的陣列。

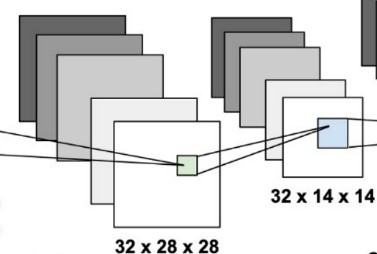

我們架構圖的例子計算一次

圖片的大小是28x28,而我們的捲積核大小為3x3,步長為1,那麼新的陣列大小就會是28(往右)/1(步長)x28(往下)/1(步長)=28x28。

圖片的大小是28x28,而我們的捲積核大小為3x3,步長為1,那麼新的陣列大小就會是28(往右)/1(步長)x28(往下)/1(步長)=28x28。

但在例子中3x3的捲積核移動26次(26+3)時就會發現超出圖片的範圍了,那該怎麼辦?這時候會使用填充的技巧,把超出外框的值做墊零(zero padding),這樣子就可以防止發生陣列大小不相等的問題了。

池化層(Pooling Layer)

當經過捲積層計算之後我們會取的一個含有圖片特徵陣列,而在那麼在這一層的工作就是利用pooling的方式處理這些特徵。

我們先來看到圖片中的MaxPooling是什麼?

我們可以看到經過

我們可以看到經過MaxPooling後的陣列大小從28x28變成了14x14這是因為MaxPooling只會保留選取範圍的最大值,這樣子可以有效的取得特徵、並移除雜訊(noize),同時縮減陣列大小從而提高運算速度。

全連接層(Fully Connected Layer)

我們在前面的兩層看到的動作都是在做特徵擷取與強化,到了這層才是真正學習的過程,概念與我們昨天說到的DNN是相同的,這邊就不在講解了,如果沒有跟上的人可以到昨天的課程【day3】Deep Neural Network MNIST手寫辨識學習相關知識

CNN實作

今天的實作會分成以下的部分: 1.導入函式庫與介紹 2.資料前處理 3.建構網路&訓練模型 4.儲存模型 5.評估模型

1.導入函式庫與介紹

import numpy as np

import tensorflow.keras

from tensorflow.keras.datasets import mnist

from tensorflow.keras.models import Sequential,load_model,model_from_json

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

from tensorflow.keras.utils import to_categorical

from PIL import Image

import matplotlib.pyplot as plt

函式庫說明:

1.keras.datasets:包含著一些著名的資料集例如:nmist、IMDB影評

2.keras.models:架構神經網路、與神經網路相關操作

3.keras.layers:創建神經網路Dense(DNN)、conv2d(CNN)

4.keras.utils:資料正規化

5.PIL:圖像相關操作

6.matplotlib.pyplot:繪畫表格

2.資料前處理

我們今天使用的架構為CNN,當使用不同架構時都需要注意他的input_shape,在CNN中輸入則是(長,寬,色彩),經過昨天的實作我們知道我們的資料是(長,寬),所以在這邊我們只需要稍微修改昨天的作法將維度reshape成(長,寬,色彩)就可以了。

#讀取資料

(x_train, y_train), (x_test, y_test) = mnist.load_data()

#CNN的輸入為(長,寬,色彩) 1代表黑白 3代表彩色

x_train = x_train.reshape(60000, 28, 28, 1)

x_test = x_test.reshape(10000, 28, 28, 1)

#正規化圖像

x_train = x_train/255

x_test = x_test/255

#將label轉換為label

y_train = to_categorical(y_train)

y_test = to_categorical(y_test)

3.建構網路&訓練模型

這次選用的激勵函式都與昨天的實作相同,我們只需加入三層網路分別是捲積層Conv2D、池化層MaxPooling2D與攤平Flatten就能使網路從DNN架構轉變成CNN架構。

#建構網路

model = Sequential()

#CNN輸入為(長*寬*色彩)

model.add(Conv2D(32, kernel_size = 3, input_shape = (28,28,1),padding="same", activation = 'relu'))

#池化層(找最大值不用激勵函數)

model.add(MaxPooling2D(pool_size = 2))

#攤平(攤平不用激勵函數)

model.add(Flatten())

#全連接層

model.add(Dense(16, activation = 'relu'))

#輸出層

model.add(Dense(10, activation = 'softmax'))

# 宣告loss finction與optimizer

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

# 開始訓練model batch_size一次丟多少資料進去訓練 epochs總共要訓練幾次

history = model.fit(x_train, y_train,

batch_size=64,

epochs=10,

verbose=1,

validation_data=(x_test, y_test))

-----------------------------------顯示-----------------------------

Epoch 10/10

938/938 [==============================] - 9s 9ms/step - loss: 0.0424 - accuracy: 0.9973 - val_loss: 0.1313 - val_accuracy: 0.9836

val_accuracy: 0.9836是不是比之前DNN跑出來的準確率還要高呢!!

4.儲存模型

在keras中model有兩種儲存的方式:分別是model.save與model.save_weights,這兩者差別就在於是否有神經網路。

若我們使用model.save儲存模型,需要使用load_model讀取檔案

#儲存model(包含網路)

model.save('model.h5')

#讀取整個model

model = load_model('model.h5')

若是使用model.save_weights,需重新定義原本的神經網路以及使用load_weights讀取檔案

#只儲存權重

model.save_weights('model_weights.h5')

#需重新定義網路

model = Sequential()

model.add(Conv2D(32, kernel_size = 3, input_shape = (28,28,1),padding="same", activation = 'relu'))

model.add(MaxPooling2D(pool_size = 2))

model.add(Flatten())

model.add(Dense(16, activation = 'relu'))

model.add(Dense(10, activation = 'softmax'))

#讀取權重

model.load_weights('model_weights.h5')

5.評估模型

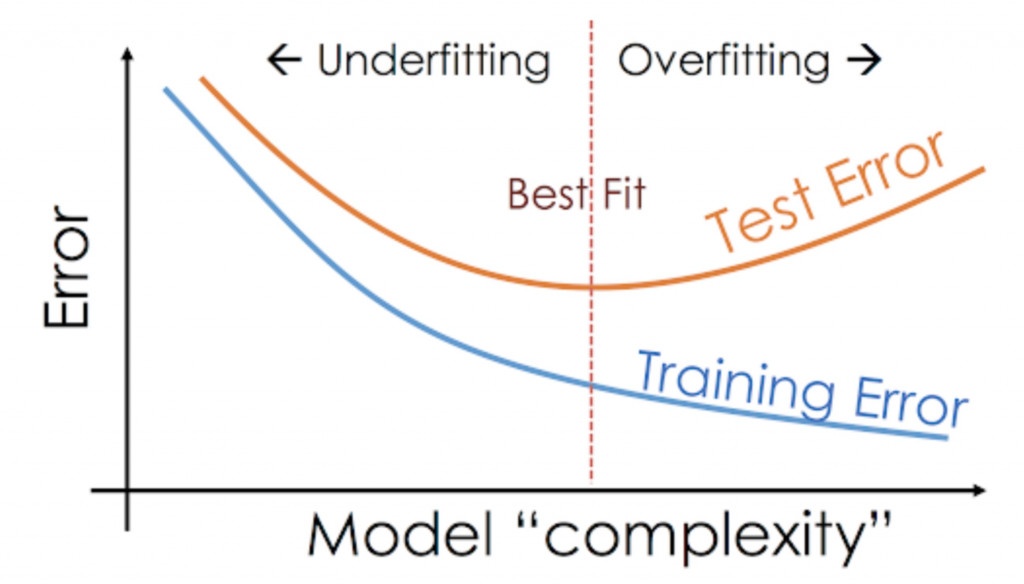

當訓練好一個模型之後要怎麼知道這模型好不好呢?我們要先了解什麼是過擬合(Overfitting)與欠擬合(Underfitting)。

圖片來源:https://www.analyticsvidhya.com/blog/2020/02/underfitting-overfitting-best-fitting-machine-learning/

過擬合(Overfitting):是因為過度學習訓練資料,而變得無法順利去預測或分辨不是在訓練資料內的其他資料,也就是在圖片的右半邊train loss下降,但test loss卻不會再變動了甚至往上升的趨勢。

欠擬合(Underfitting):通常會發生在模型參數過少、模型結構過於簡單或資料過於雜亂時,導致無法捕捉到資料中的規律的現象,也就是我們圖片的左半邊,test loss始終追不上train loss。

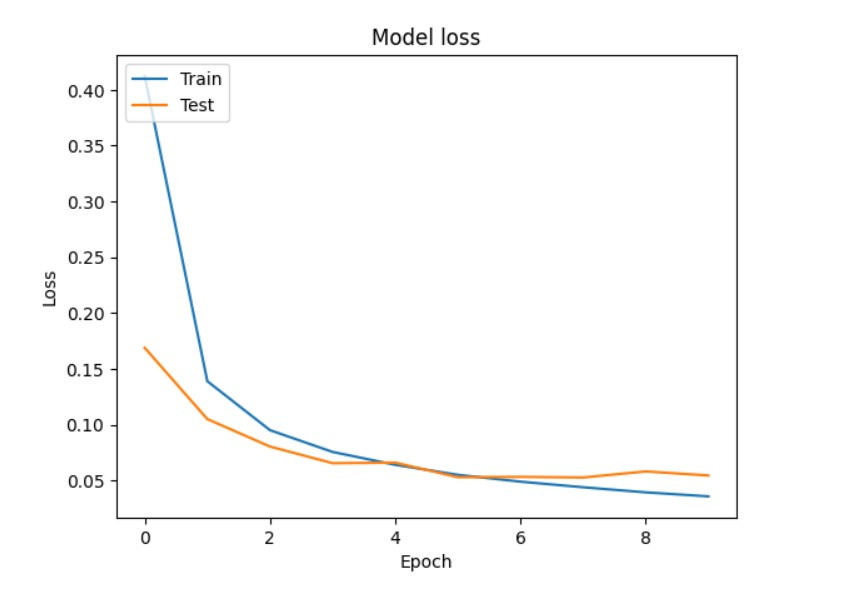

現在我們開始寫程式來繪出train loss與test loss的折線圖找到最好的訓練次數吧!!

我們先來查看訓練過程中的到的loss值

print('train loss:',history.history['loss'],'\n\ntest loss:',history.history['val_loss'])

------------------------------------顯示------------------------------------

train loss: [0.41220638155937195, 0.1390567123889923, 0.09521930664777756, 0.07572223246097565, 0.06420597434043884, 0.05522913485765457, 0.049094390124082565, 0.04410300403833389, 0.03952856734395027, 0.03593530133366585]

test loss: [0.16896437108516693, 0.10513907670974731, 0.08054570108652115, 0.06564835458993912, 0.06614525616168976, 0.05308758467435837, 0.053389910608530045, 0.052831731736660004, 0.05826638638973236, 0.05463290959596634]

我們可以看到keras會把每次epoch計算的loss值存成一個list,那我們就可以使用matplotlib.pyplot快速的畫出一張折線圖。

#train loss

plt.plot(history.history['loss'])

#test loss

plt.plot(history.history['val_loss'])

#標題

plt.title('Model loss')

#y軸標籤

plt.ylabel('Loss')

x軸標籤

plt.xlabel('Epoch')

#顯示折線的名稱

plt.legend(['Train', 'Test'], loc='upper left')

#顯示折線圖

plt.show()

這樣我們就能觀察到在第5或6次就會是模型最佳的結果

那們今天就到這邊,到現在程式都很簡單吧只需要瞭解一些理論就能簡單的實作出來,明天會來教近期最後一堂理論課程LSTM,之後就來玩點日常生活中AI的應用吧

完整程式碼

import numpy as np

import tensorflow.keras

from tensorflow.keras.datasets import mnist

from tensorflow.keras.models import Sequential,load_model,model_from_json

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

from tensorflow.keras.utils import to_categorical

from PIL import Image

import matplotlib.pyplot as plt

#讀取資料

(x_train, y_train), (x_test, y_test) = mnist.load_data()

#CNN的輸入為(長,寬,色彩) 1代表黑白 3代表彩色

x_train = x_train.reshape(60000, 28, 28, 1)

x_test = x_test.reshape(10000, 28, 28, 1)

#正規化圖像

x_train = x_train/255

x_test = x_test/255

#將label轉換為label

y_train = to_categorical(y_train)

y_test = to_categorical(y_test)

#建構網路

model = Sequential()

#CNN輸入為28*28*1

model.add(Conv2D(32, kernel_size = 3, input_shape = (28,28,1),padding="same", activation = 'relu'))

#池化層

model.add(MaxPooling2D(pool_size = 2))

#攤平

model.add(Flatten())

#全連接層

model.add(Dense(16, activation = 'relu'))

#輸出層

model.add(Dense(10, activation = 'softmax'))

model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy'])

history = model.fit(x_train, y_train,

batch_size=128,

epochs=10,

verbose=1,

validation_data=(x_test, y_test))

plt.plot(history.history['loss'])

plt.plot(history.history['val_loss'])

plt.title('Model loss')

plt.ylabel('Loss')

plt.xlabel('Epoch')

plt.legend(['Train', 'Test'], loc='upper left')

plt.show()

#儲存model(包含網路)

model.save('model.h5')

#讀取整個model

model = load_model('model.h5')

#只儲存權重

model.save_weights('model_weights.h5')

#需重新定義網路

model = Sequential()

model.add(Conv2D(32, kernel_size = 3, input_shape = (28,28,1),padding="same", activation = 'relu'))

model.add(MaxPooling2D(pool_size = 2))

model.add(Flatten())

model.add(Dense(16, activation = 'relu'))

model.add(Dense(10, activation = 'softmax'))

#讀取權重

model.load_weights('model_weights.h5')

爬蟲與股票預測-長短期記憶模型(Long short-term memory) (上)

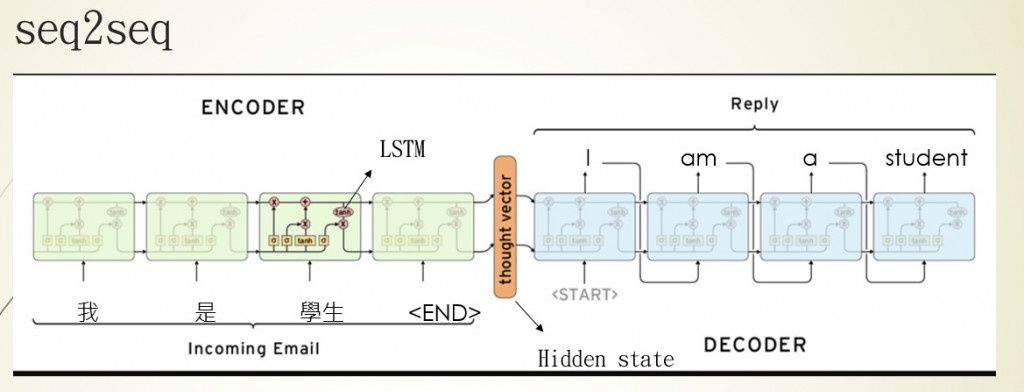

遞迴神經網路(Recurrent Neural Networks)

在開始說明LSTM前,我們要先了解一下什麼是RNN架構。

圖片來源:李弘毅老師的youtube影片

先說明圖片中的一些重要參數,X1~Xn是我們帶有時間順序的輸入,像是股票的走勢、天氣的溫度、文本的文字,都是帶有時間的數據。H0~Hn是經過RNN計算過後保留下來的資料,初始狀態(H0)這一個狀態可以是0(未經過訓練),經過每一個輸入(X與上個節點的H)就會更改H的數值並與下一個節點進行運算,使程式有將資訊傳遞的效果。而Y1~Y8是將每一節點的輸出單獨取出的結果,並不會與下個節點計算。

舉一個例子來說:

假設一週的天氣數據是[X1,X2,X3,X4,X5,X6,X7],我們要讓RNN的神經網路預測第8天的數據,那在RNN的過程就會像是這個樣子第一節點輸入(H0,X1)->第一節點輸出(Y1,H1)->第二節點輸入(H1,X2)->第二節點輸出(Y2,H2)...第8節點輸出(Y8,H8)。

通過H傳遞每一節點的資料,使神經網路能夠瞭解前幾個節點的資料,從而資料帶有時間序而最終訓練的結果也就是我們的Hn狀態,此時狀態會與Yn相同,因為Y跟H是相同的,差別在於是否會進入到下個節點進行運算。

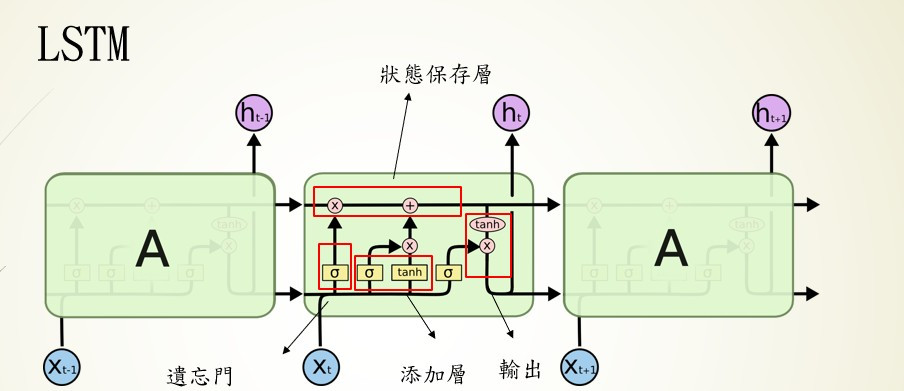

長短期記憶模型(Long Short-Term Memory)

LSTM是我們剛剛講解到的RNN模型的改良版,因為RNN模型有一個重大的缺點,就在於他是短期記憶(Short Term)我們可以看到,每節點的輸出是會被作為輸入不斷的被計算的,也就意味著會被不斷的稀釋,大概經過3~4節點最開始的輸入就被稀釋光了,LSTM則改良了這個問題。

我們把LSTM拆解為4個區塊:

我們把LSTM拆解為4個區塊:狀態保存層(Cell State)、遺忘門層(Forget Gate Layer)、添加層、輸出層(Output Layer)。

狀態保存層(Cell State)

前面提到RNN的資料會隨著計算迅速消失,為瞭解決這個問題在LSTM中就將資料獨立儲存,並通過,遺忘門、添加層等運算,保留相關的資訊。

遺忘門層(Forget Gate Layer)

在這層中會對上一個節點的輸出與當前輸入的使用sigmoid計算,將上個節點的輸出資料傳送給狀態保存層,並丟棄無用的資料。簡單來說就是會忘記不重要的資料,保留重要的資料。

添加層

當然有丟棄資料的方式也要有新增資料的方法,所以我們這層的任務就是找到重要的資訊,將當前節點的輸入通過sigmoid計算,並通過tanh縮放資料權重,最後將資料傳送給狀態保存層。

輸出層(Output Layer)

這階段的作法與添加層的作法相似,也是通過sigmoid與tanh的計算取的所需要的資料,差別在於這次資料的來源是狀態保存層。

在這邊作一個簡易的統整:

狀態保存層:負責保留每個節點的資料

遺忘門層:輸入是上一個節點的輸出與當前輸入使用sigmoid計算,保留上個節點的輸出

添加層:輸入是上一個節點的輸出與當前輸入使用sigmoid與tanh計算,保留當前輸入

輸出層:輸入是狀態保存層與當前輸入使用sigmoid與tanh計算,重新計算下個節點的輸入

到這裡是不是瞭解LSTM中的構造了呢?但在開始LSTM之前我們來先來學一下爬蟲,準備我們LSTM所需要的資料

網路爬蟲

在python有兩個比較著名的爬蟲函式庫分別是requests與selenium,前者難度較高,所以今天會先採用selenium作為基礎教學,後續的課程中再教requests那們進入今天的正題我們先將程式分為幾個部分:

1.架構環境

2.導入函式庫與介紹

3.建立瀏覽器環境

4.迴圈取得網站資料

5.整理資料並存檔

1.架構環境

首先我們先到以下網址下載載驅動程式:

先找到自己瀏覽器的版本(這邊我就使用chrome作範例)到chrome://settings/help 查看瀏覽器版本

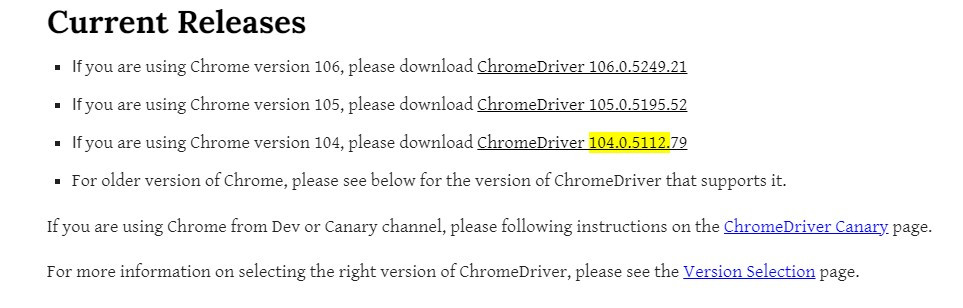

到我們驅動程式的網站下載對應版本(我的版本是104版本)

到我們驅動程式的網站下載對應版本(我的版本是104版本)

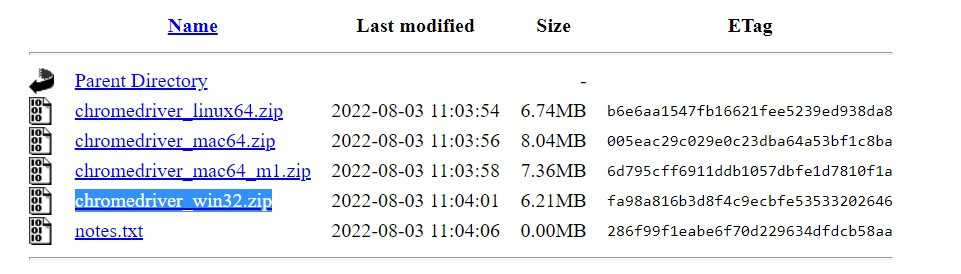

點進去後下載chromedriver_win32.zip(windows為例)

點進去後下載chromedriver_win32.zip(windows為例)

之後解壓縮到要寫程式的資料夾就可以了

之後解壓縮到要寫程式的資料夾就可以了

再來我們安裝一下今天要使用到的函式庫不會的可以到我第一天的教學【day1】python&函式庫 安裝與介紹

再來我們安裝一下今天要使用到的函式庫不會的可以到我第一天的教學【day1】python&函式庫 安裝與介紹

pip install selenium

pip install bs4

pip install pandas

pip install sklearn

2.導入函式庫與介紹

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from bs4 import BeautifulSoup

from time import sleep

import pandas as pd

1.selenium:動態爬蟲

2.bs4:分析html網址

3.time:時間相關操作

4.pandas:excel相關操作

3.建立瀏覽器環境

首先我們要知道網站會防止分散式阻斷服務(DDoS),所以會阻擋請求太頻繁或是爬蟲的請求標頭(request header)所以我們需要更改selenium的user agent。

#設定user agent防止網站鎖IP

chrome_options = Options()

chrome_options.add_argument("user-agent=Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/104.0.0.0 Safari/537.36")

#指定驅動與導入設定

chrome = webdriver.Chrome('chromedriver',options=chrome_options)

設定好瀏覽器的環境後我們就可以開始解析網站了

4.迴圈取得網站資料

首先我們前往臺灣證券交易所的網站(臺積電股票為例),但這個網站卻只有2013/10月的股票數據,所以我們需要使用迴圈幫助我們。

https://www.twse.com.tw/exchangeReport/STOCK_DAY?response=html&date=20131001&stockNo=2330

先分析一下url,可以看到兩個參數data=20131001與stockNo=2330,這兩個參數很明顯的一個是日期,另一個是股票編號,所以我們可以統整出以下格式。

https://www.twse.com.tw/exchangeReport/STOCK_DAY?response=html&date={年/月/日}&stockNo={股票編號}

之後就可以使用迴圈去請求不同頁面的數據

#range的內部參數是range(開始, 結尾, 一次加多少)

#2010~2022年

for y in range(2010,2023):

#1~12月

for m in range(1,13):

#網址格式為yyyy/mm/dd 不能少一碼所以要補0

if m <10:

#m的格式是int所以要轉成str才能作文字的相加

m = '0'+str(m)

url = f'https://www.twse.com.tw/exchangeReport/STOCK_DAY?response=html&date={y}{m}01&stockNo=2330'

接下來我們來操作程式前往網站並獲取網站資料

#前往網站

chrome.get(url)

#獲取網站資料

soup = BeautifulSoup(chrome.page_source, 'html.parser')

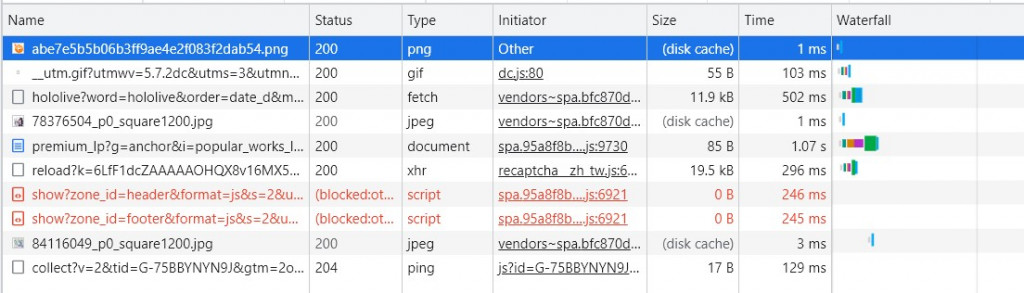

接下來我們到網站按下F12可以看到一html的程式碼,可以觀察到我們需要的資料都在tbody>tr這個標籤裡面。

之後就可以利用bs4所提供的CSS選擇器來找到我們要的資料節點,就可以獲取我們想要的資料

soup.select('tbody > tr')

。

5.整理資料並存檔

我們可以看到soup.select('tbody > tr')獲取到的資料長這樣子

<tr>

<td>99/01/04</td>

<td>39,511,138</td>

<td>2,557,720,928</td>

<td>65.00</td>

<td>65.00</td>

<td>64.00</td>

<td>64.90</td>

<td>+0.40</td>

<td>8,255</td>

</tr>

我們所需要的資料只有裡面的數值,所以我們先把資料轉成str就能取得一個比較乾淨的結果

print(tr.text)

----------顯示----------

99/01/19

47,541,231

2,970,283,048

63.00

63.20

62.00

62.50

-0.40

14,132

但有沒有發現這些資料自動換行了,這代表這些字串有一個叫做\n的特殊符號,在程式中\n代表換行符號的意思,所以我們要先將這些資料移除掉,並返回list讓我們更好的處理資料,在這邊我們只要使用split()就可以了

#split('需要切割的字')返回是list

td = tr.text.split('\n')

----------------顯示----------------

['', ' 99/01/29', '98,124,608', '5,948,654,037', '60.10', '61.50', '59.40', '61.50', '+1.50', '18,337', '']

接下來為了存成csv檔,所以我們先創立一個dict當作存放資料的地方

#建立我們資料要的dict

data = {'日期':[],

'成交股數':[],

'成交金額':[],

'開盤價':[],

'最高價':[],

'最低價':[],

'收盤價':[],

'漲跌價差':[],

'成交筆數':[]}

並且通過append將所有的資料加入到個別的索引

#注意td[0] 是 ''

data['日期'].append(td[1])

data['成交股數'].append(td[2])

data['成交金額'].append(td[3])

data['開盤價'].append(td[4])

data['最高價'].append(td[5])

data['最低價'].append(td[6])

data['收盤價'].append(td[7])

data['漲跌價差'].append(td[8])

data['成交筆數'].append(td[9])

就能使用pandas裡面的功能將資料存成csv啦

#dict轉成dataframe

df = pd.DataFrame(data)

#存成csv檔案

df.to_csv("data.csv")

完整程式碼(爬蟲)

from selenium import webdriver

from selenium.webdriver.chrome.options import Options

from bs4 import BeautifulSoup

from time import sleep

import pandas as pd

#設定user agent防止網站鎖IP

chrome_options = Options()

chrome_options.add_argument("user-agent=Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/104.0.0.0 Safari/537.36")

#指定驅動與導入參數

chrome = webdriver.Chrome('chromedriver',options=chrome_options)

#建立我們資料要的dict

data = {'日期':[],

'成交股數':[],

'成交金額':[],

'開盤價':[],

'最高價':[],

'最低價':[],

'收盤價':[],

'漲跌價差':[],

'成交筆數':[]}

#設定年月日(2010~2022)

for y in range(2010,2023):

for m in range(1,13):

#網址格式為yyyy/mm/dd 不能少一碼所以要補0

if m <10:

#m的格式是int所以要轉成str才能作文字的相加

m = '0'+str(m)

url = f'https://www.twse.com.tw/exchangeReport/STOCK_DAY?response=html&date={y}{m}01&stockNo=2330'

#前往網站

chrome.get(url)

#獲取網站資料

soup = BeautifulSoup(chrome.page_source, 'html.parser')

#透過CSS選擇器找到在tbody裡面所有的tr標籤

for tr in soup.select('tbody > tr'):

#將\n透過split()分割

td = tr.text.split('\n')

data['日期'].append(td[1])

data['成交股數'].append(td[2])

data['成交金額'].append(td[3])

data['開盤價'].append(td[4])

data['最高價'].append(td[5])

data['最低價'].append(td[6])

data['收盤價'].append(td[7])

data['漲跌價差'].append(td[8])

data['成交筆數'].append(td[9])

print(data)

#防止過度請求網站被鎖定IP

sleep(10)

#dict轉成dataframe

df = pd.DataFrame(data)

#存成csv檔案

df.to_csv("data.csv")

那今天就先到這邊好了,其實今天是想把東西全部教完的,但發現內容太多了,所以明天會接續今天的內容把LSTM實作做完,那我們明天再見。

爬蟲與股票預測-長短期記憶模型(Long short-term memory) (下)

LSTM股票預測

- 1.導入函式庫與介紹

- 2.資料前處理

- 3.架構模型與訓練

- 4.效能評估

1.導入函式庫與介紹

import numpy as np

import pandas as pd

import tensorflow.keras

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

from sklearn.preprocessing import MinMaxScaler

1.numpy:陣列相關操作

2.keras.models:架構神經網路、與神經網路相關操作

3.keras.layers:創建神經網路

4.sklearn.preprocessing:數值正規化

5.matplotlib.pyplot:繪畫表格

2.資料前處理

首先我們先從pandas讀取昨天爬蟲拿到的csv檔,沒有的人可以觀看這篇【day5】爬蟲與股票預測-長短期記憶模型(Long short-term memory) (上)

df = pd.read_csv('data.csv')

我們在課堂的一開始有說到,大部分深度學習模型都要把數值壓縮到0~1之間,不只能加速收斂速度,所以今天我們股票預測要使用的方式是最大最小正規化(Min-Max Normalization)

def Min_Max_normalization(name):

#調整維度成[[資料1],[資料2]]

name = name.reshape(-1, 1)

#正規化數值

scaler = MinMaxScaler(feature_range=(0, 1)).fit(name)

sc = scaler.transform(name)

#[維度還原]

return sc.reshape(-1)

#df[row]:可以直接取一整排的數值回傳的type是dataframe

#values:轉成dataframe轉成array

open_p = Min_Max_normalization(df['開盤價'].values)

max_p = Min_Max_normalization(df['最高價'].values)

min_p = Min_Max_normalization(df['最低價'].values)

fin_p = Min_Max_normalization(df['收盤價'].values)

#replace(old,new)這裡是將文字中的,去除掉

len_p = np.array([int(i.replace(',','')) for i in df['成交筆數'].values])

len_p = Min_Max_normalization(len_p)

接下來我們來創建自己的資料集(Date set),首先我們取每10天的資料預測每第11天的資料,並個資料都要帶有5筆特徵(開盤價、最高價、最低價、收盤價、成交筆數)

data = []

tmp = []

label = []

#最後一筆label的範圍是最大數量-11天

for cnt in range(len(open_p)-11):

#獲取10天的資料

open_10 = open_p[cnt:cnt+10]

max_10 = max_p[cnt:cnt+10]

min_10 = min_p[cnt:cnt+10]

fin_10 = fin_p[cnt:cnt+10]

len_10 = len_p[cnt:cnt+10]

#zip可以將每筆資料都同時丟進for迴圈中

for i,j,k,m,n in zip(open_10,max_10,min_10,fin_10,len_10):

tmp.append([i, j, k, m, n])

data.append(tmp)

tmp = []

取得收盤價

label.append(fin_p[cnt+11:cnt+12][0])

這樣子我們就能得到一組擁有10天資料5個特徵的訓練資料了(資料數量,天數,特徵)

接下來我們把資料分8:2切割我們的訓練數據與測試數據

split_cnt = int(len(data)*0.8)

x_train,y_train = np.array(data[0:split_cnt]),np.array(label[0:split_cnt])

x_test,y_test = np.array(data[0:len(data)-split_cnt]),np.array(label[0:len(data)-split_cnt])

這樣資料前處理就完成了~~

3.架構模型

今天的模型架構也很簡單,但有一個比較需要注意的return_sequences = True,使我們能夠考慮到前後天的資料,而不是隻考慮到昨天的結果

model= Sequential()

model.add(LSTM(128,input_shape=(10, 5),return_sequences=True,activation='relu'))

model.add(LSTM(64,return_sequences=False,activation='relu'))

model.add(Dense(1))

#mse為跑回歸任務的其中一個loss function

#回歸任務沒有acc只有loss

model.compile(loss='mean_squared_error',optimizer='adam')

# 開始訓練model batch_size一次丟多少資料進去訓練 epochs總共要訓練幾次

history = model.fit(x_train, y_train,

batch_size=64,

epochs=10,

verbose=1,

validation_data=(x_test, y_test))

-------------------------------顯示-------------------------------

Epoch 10/10

39/39 [==============================] - 0s 8ms/step - loss: 7.0062e-05 - val_loss: 8.8297e-06

4.效能評估

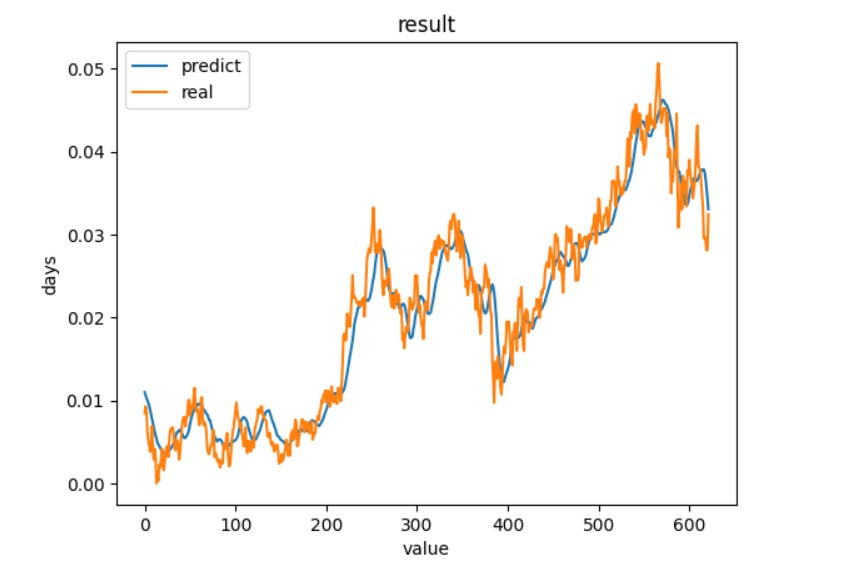

我們直接拿實際值與預測出來的數值作比對

y_predicted = model.predict(x_test)

#預測

plt.plot(y_predicted)

#實際值

plt.plot(y_test)

#標題

plt.title('result')

#y軸標籤

plt.ylabel('days')

#x軸標籤

plt.xlabel('value')

#顯示折線的名稱

plt.legend(['predict', 'real'], loc='upper left')

#顯示折線圖

plt.show()

我們可以看到訓練出來的結果還是有貼近實際值,但實際值下降時,預測有時候是上升的,因為股票預測考慮的因素不只有這一些,考慮更多因素說不定能有更好的結果。

完整程式碼(LSTM)

import numpy as np

import pandas as pd

import tensorflow.keras

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

from sklearn.preprocessing import MinMaxScaler

import matplotlib.pyplot as plt

def Min_Max_normalization(name):

name = name.reshape(-1, 1)

scaler = MinMaxScaler(feature_range=(0, 1)).fit(name)

sc = scaler.transform(name)

return sc.reshape(-1)

df = pd.read_csv('data.csv')

open_p = Min_Max_normalization(df['開盤價'].values)

max_p = Min_Max_normalization(df['最高價'].values)

min_p = Min_Max_normalization(df['最低價'].values)

fin_p = Min_Max_normalization(df['收盤價'].values)

len_p = np.array([int(i.replace(',','')) for i in df['成交筆數'].values])

len_p = Min_Max_normalization(len_p)

data = []

tmp = []

label = []

for cnt in range(len(open_p)-11):

open_10 = open_p[cnt:cnt+10]

max_10 = max_p[cnt:cnt+10]

min_10 = min_p[cnt:cnt+10]

fin_10 = fin_p[cnt:cnt+10]

len_10 = len_p[cnt:cnt+10]

for i,j,k,m,n in zip(open_10,max_10,min_10,fin_10,len_10):

tmp.append([i, j, k, m, n])

data.append(tmp)

tmp = []

label.append(fin_p[cnt+11:cnt+12][0])

split_cnt = int(len(data)*0.8)

x_train,y_train = np.array(data[0:split_cnt]),np.array(label[0:split_cnt])

x_test,y_test = np.array(data[0:len(data)-split_cnt]),np.array(label[0:len(data)-split_cnt])

model= Sequential()

model.add(LSTM(128,input_shape=(10, 5),return_sequences=True,activation='relu'))

model.add(LSTM(64,return_sequences=False,activation='relu'))

model.add(Dense(1))

model.compile(loss='mean_squared_error',optimizer='adam')

# 開始訓練model batch_size一次丟多少資料進去訓練 epochs總共要訓練幾次

history = model.fit(x_train, y_train,

batch_size=64,

epochs=10,

verbose=1,

validation_data=(x_test, y_test))

y_predicted = model.predict(x_test)

#預測

plt.plot(y_predicted)

#實際值

plt.plot(y_test)

#標題

plt.title('result')

#y軸標籤

plt.ylabel('days')

#x軸標籤

plt.xlabel('value')

#顯示折線的名稱

plt.legend(['predict', 'real'], loc='upper left')

#顯示折線圖

plt.show()

到這邊基礎技術基本上都教完了~明天來教一下如何使用pytorch吧

解析gz檔案 & 使用Pytorch做CIFAR10影像辨識 (上)

我們前幾天用的深度學習函式庫是Tensorflow作為後端,並用keras快速實現深度神經網路,這樣的做法雖然可以簡易的完成一些簡易的AI程式,但無法實現複雜的神經網路及預訓練模型(pre-trained model),所以通常會使用keras學習AI的基礎知識,再來使用Tensorflow或Pytorch作為最終的訓練工具,我這邊會推薦使用Pytorch,所以之後的課程都會以Pytorch為主

解析gz檔

在我們【day3】來辨識圖像-深度神經網路(Deep Neural Network)的課程中,可以看到透過keras下載的資料集是一個無法打開的文件,須通過程式內部的解析才能瞭解內容,但如果我今天想要裡面的圖片存在自己的電腦裡或做為資料集使用呢?所以今天要來教如何解開gz檔,在獲得資料的同時也能讓你更理解圖片維度的意義。

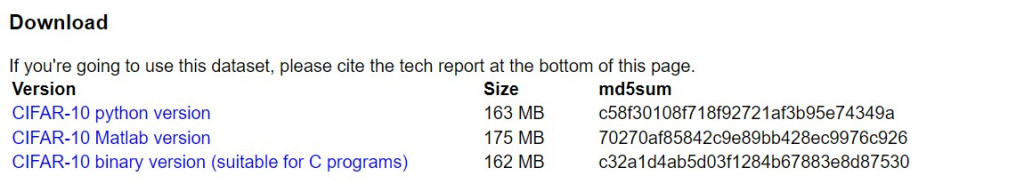

- 1.下載資料與安裝函式庫

- 2.讀取資料並整理資料

- 3.迴圈與儲存資料

下載資料與安裝函式庫

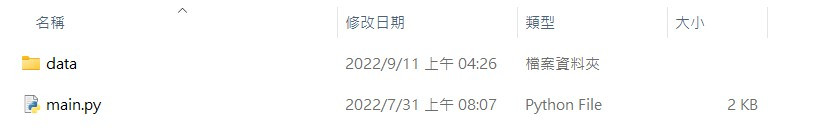

首先我們先到下載資料官方網站裡面下載CIFAR-10 python version

接下來我們把gz檔解壓縮,並且創一個叫做data的資料夾將data_batch_1~data_batch_5與test_batch存放起來,並且在外面創建一個python檔案,此時我們的畫面應該會長這個樣子

接下來是安裝函式庫

pip install opencv-python

這樣子就可以開始寫程式啦

讀取資料並整理資料

先來導入今天需要的函式庫

import pickle as pk

import numpy as np

import cv2

import os

接下來看到官方網站中有教我們該如何打開gz的方式,我們先觀察這樣會回傳什麼樣的資料。

def unpickle(file):

with open(file, 'rb') as fo:

dict = pickle.load(fo, encoding='bytes')

return dict

print(unpickle('data/data_batch_1'))

----------------------------顯示----------------------------

{b'batch_label': b'training batch 1 of 5',

b'labels': [label資料]

b'data': array([[圖片資料]], dtype=uint8)

b'filenames': [檔案名稱]}

可以看到這個資料了型態會是一個dict,每一個資料裡面都是一個陣列,我們只需要將labels作為資料夾分類使用filenames作為data的圖片的檔名就可以存檔....個鬼,在官方網站中有這樣一段話

3072 bytes are the values of the pixels of the image. The first 1024 bytes are the red channel values, the next 1024 the green, and the final 1024 the blue. The values are stored in row-major order, so the first 32 bytes are the red channel values of the first row of the image.

(每張圖片共3072個資料,第一個1024個為紅色的通道的資料,接下來是1024個綠色通道,最後是1024個為藍色,每個資料都是按照優先順序排列的,因此前32個資料是第一行的紅色資料)。

在這裡就需要先說明一下電腦儲存影像的方式了首先我們可以知道三原色(紅R、綠G、藍B)可以組合出任一的顏色,所以我們只需要給予一個像素一組紅、綠、藍的資料再將這個資料組合在一起就可以變成一張圖片,在CIFAR10中圖片大小是32x32的,所以在文章中所提到的3072筆其實就是32x32x3。所以按照官方的意思我們在圖片1x1的位子就會是資料中的第0筆(R) 第1024筆(G) 第2048筆(B)並依照這個格式組成一張32x32的圖片。

我們先改寫一下官方的範例讓我們更好拿到資料

def unpickle(file):

#開啟檔案視為2進位

with open(file, 'rb') as fo:

#解析開啟後的gz檔

gz_dict = pk.load(fo, encoding='bytes')

return gz_dict[b'labels'],gz_dict[b'filenames'],gz_dict[b'data']

labels,names, datas = unpickle(f'data/data_batch_1')

接下來將每筆data放入迴圈中並將通道分成R,G,B

for data in datas:

R = data[:1024]

G = data[1024:2048]

B = data[2048:3072]

最後我們把數據組成圖片一張圖片

img,tmp = [],[]

#enumerate 計數程式用法與range(len(data))回傳值是(計數的值,資料)

for cnt,(r,g,b) in enumerate(zip(R,G,B),1):

#創立一個像素(在這邊使用b,g,r是因為opencv存檔的格式是bgr)

tmp.append([b, g, r])

#每32個像素換下一列

if cnt % 32 == 0:

#將整行的像素存入陣列中

img.append(tmp)

tmp = []

迴圈與儲存資料

剛剛只讀取了data_batch_1這個檔案,但我們今天需要重複6次相同的動作,這時我們可以透過os.listdir讀取資料夾內容的名稱,並透過迴圈讀取資料。

#os.listdir('路徑')回傳值為[檔名1~檔名n]

for path in os.listdir('data'):

labels,names, datas = unpickle(f'data/{path}')

為了儲存圖片可以使用makedirs創建資料夾,但makedirs在迴圈中就會因為創建過資料夾而導致程式錯誤,這邊就能使用try...except的語句做處理。

#嘗試做動作

try:

os.makedirs(f'pic/train/{label}')

os.makedirs(f'pic/test/{label}')

#若無法執行則會執行這裡

except:

#不做任何事情

pass

運用opencv儲存剛剛整理好的影像

cv2.imwrite(path, np.array(img))

可以知道資料集需要分成測試數據集與訓練數據集,在CIFAR10中test_batch就是我們的訓練數據集,所以我們就能用if判斷該資料是訓練還是測試資料。

#測試數據集

if path == 'test_batch':

#把資料存進剛剛建立好的資料夾中 過濾掉檔名裡面的'b'與'符號

cv2.imwrite(f'pic/test/{label}/{str(name)[2:-1]}', np.array(img))

else:

cv2.imwrite(f'pic/train/{label}/{str(name)[2:-1]}', np.array(img))

最後讓我們把程式組合起來

完整程式碼

import pickle as pk

import numpy as np

import cv2

import os

def unpickle(file):

with open(file, 'rb') as fo:

gz_dict = pk.load(fo, encoding='bytes')

return gz_dict[b'labels'],gz_dict[b'filenames'],gz_dict[b'data']

for path in os.listdir('data'):

labels,names, datas = unpickle(f'data/{path}')

for label, name, data in zip(labels,names,datas):

try:

os.makedirs(f'pic/train/{label}')

os.makedirs(f'pic/test/{label}')

except:

pass

R = data[:1024]

G = data[1024:2048]

B = data[2048:3072]

img,tmp = [],[]

for cnt,(r,g,b) in enumerate(zip(R,G,B),1):

tmp.append([b, g, r])

if cnt % 32 == 0:

img.append(tmp)

tmp = []

if path == 'test_batch':

cv2.imwrite(f'pic/test/{label}/{str(name)[2:-1]}', np.array(img))

else:

cv2.imwrite(f'pic/train/{label}/{str(name)[2:-1]}', np.array(img))

這樣子可以得到資料啦,明天先來說說GPU加速與再來開始pytorch的教學

解析gz檔案 & 使用Pytorch做CIFAR10影像辨識 (下)

為何要使用GPU加速

在實作CNN與LSTM時的因為資料量較小隻需用到CPU運算,但後續課程中的資料會越來越多,所以運算時間會越來越久,這時就會使用到GPU去加速程式。

我們先了解GPU為何能夠加速程式就要先知道GPU的構造,GPU是由許多的乘數累加器(Multiply Accumulate)組成,這種運算的動作是將資料相乘後加上累加器後再存入累加器(累加器1 <- 累加器1 + 資料1x資料2),而在神經網路中可以將矩陣放入累加器中運算,且在乘數累加器中只需使用一個指令就能完成上述的動作,從而提高運算的速度,簡單來說就是GPU能夠用簡短的方式傳輸大量資料。

CIFAR10影像辨識

今天的課程會有許多【day3】來辨識圖像-深度神經網路(Deep Neural Network)與【day4】找到圖片的特徵-捲積神經網路(Convolutional neural network)的知識與一些延伸,若是有不瞭解的地方可以回顧一下。

- 1.Pytorch版本安裝

- 2.函式庫介紹與安裝

- 3.創建資料集

- 4.架構神經網路

- 5.訓練神經網路

Pytorch版本安裝

我們前幾天再安裝函式庫都是使用pip install 函式庫名稱安裝程式,但使用這種方式安裝pytorch卻會發現是CPU版本,那麼該怎麼安裝GPU版本呢?

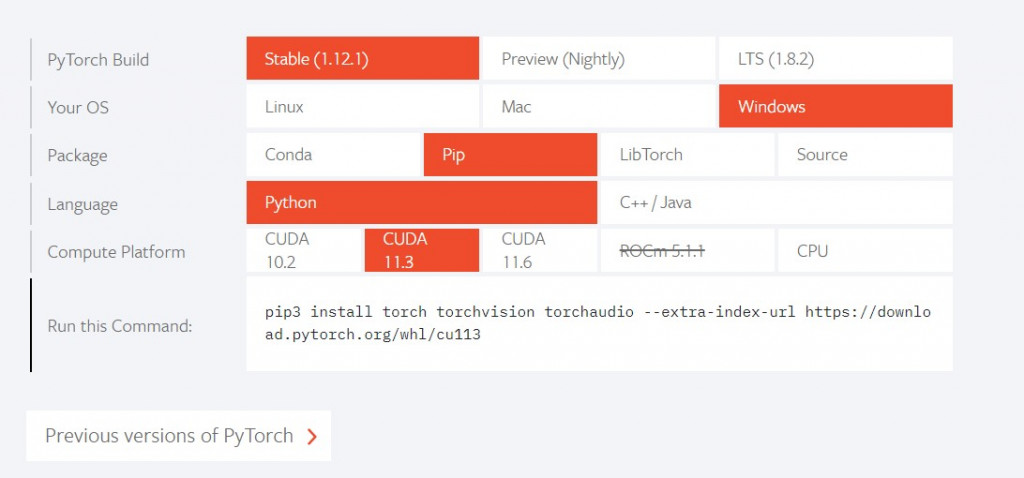

先到Pytorch的官方網站會看到INSTALL PYTORCH,之後選擇安裝的方式(pip)與cuda版本(基本上都是11.3),就會得到一串pip的指令

之後輸入就安裝完畢了

pip3 install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113

函式庫介紹與安裝

#如果到現在的課程都有跟上,那應該只會缺少tqdm函式庫

pip install tqdm

接下來介紹一下今天會使用的函式庫

#系統相關操作

import os

#深度學習函式庫

import torch

#神經元架構與損失函數

import torch.nn as nn

#激勵函數

import torch.nn.functional as F

#優化器

import torch.optim as optim

#圖像前處理

import torchvision.transforms as transforms

#矩陣操作

import numpy as np

#圖像操作

from cv2 import imread

#創建資料集

from torch.utils.data import Dataset, DataLoader

#顯示進度條

from tqdm import tqdm

創建資料集

我們前幾天的實作都是先將資料放入一個array中,再將array給予神經網路去運算,但是在pytorch中不會使用這種方式,因為pytorch沒辦法像keras那樣指定batch size與epoch,所以在pytorch中會先將變成dataset後再轉換成dataloader,才能夠指定batch size等參數,我們先看一下pytorch創建dataset的方式。

#繼承Dataset這一個class(需要繼承pytorch設定好的class並新增自己的資料)

class dataset(Dataset):

#初始化資料的地方

def __init__(self,data):

#創建資料的地方

#每次訓練時會通過__getitem__取得我們需要訓練的資料

def __getitem__(self,index):

#訓練當前的index與資料

#判斷資料的大小

def __len__(self):

#判斷index的上限

return len(self.data)

在這邊需要注意若我們需要的處理資料(讀檔、正規化),需要在init內完成,而不是在getitem裡面,因為pytorch在訓練的時候會從getitem這一個function裡取資料,如果寫在裡面會使每取一筆資料,就需要重新處理一次,這樣子會導致程式訓練的時間變得更久。

若使用GPU訓練的人要注意處理資料時千萬不要在建立資料時,將資料放入GPU中處理,例如:

def __init__(self,data):

#cuda()會將資料放入顯卡

self.data = data.cuda()

這樣子會將所有的資料放入顯卡當中,且不會釋放,若是要將資料放入GPU中,應先將資料變成dataloader的形式再使用cuda()放入到GPU當中。

接下來開始處理昨天解析出來的CRFAR10圖像,透過昨天學習到的listdir讀取圖片並放到list當中。

data = []

for label in os.listdir(path):

for pic in os.listdir(path + '/' + label):

#cv2.imread(path)可以將圖片轉換為array

cv_pic = imread(f'{path}/{label}/{pic}')

data.append([cv_pic, int(label)])

之後需要對圖片正規化,這裡可以利用transforms.Compose()定義我們想要做的操作。

#將資料轉化成Tensor後Normalize

transform = transforms.Compose([transforms.ToTensor(),

transforms.Normalize((0.5,0.5,0.5),(0.5,0.5,0.5))

])

這樣就可以把transform做為一個function使用了

transform(data)

我們將整個程式組合起來,這樣就可以創建資料集了

class CRFAR10(Dataset):

def __init__(self, path, transform):

self.data = []

for label in os.listdir(path):

for pic in os.listdir(path + '/' + label):

cv_pic = imread(f'{path}/{label}/{pic}')

self.data.append([cv_pic, int(label)])

def __getitem__(self,index):

datas = transform(self.data[index][0])

labels = torch.tensor(self.data[index][1])

return datas, labels

def __len__(self):

return len(self.data)

transform = transforms.Compose([transforms.ToTensor(),

transforms.Normalize((0.5,0.5,0.5),(0.5,0.5,0.5))

])

train_set = CRFAR10(r'pic/train/', transform)

test_set = CRFAR10(r'pic/test/', transform)

train_loader = DataLoader(train_set, batch_size = 128,shuffle = True, num_workers = 0)

test_loader = DataLoader(test_set, batch_size = 128, shuffle = True, num_workers = 0)

架構神經網路

先來看pytorch中該怎麼架構神經網路的格式。我們需要在init定義神經網路的種類與每層的輸入大小,並且使用forward來執行動作。

#繼承nn.Module

class CNN(nn.Module):

def __init__(self):

#呼叫nn.Module裡面init的資料

super().__init__()

#定義神經網路

def forward(self, x):

#定義操作

知道格式後,就可以來架構神經網路了,今天要的網路構造如下:

#![allow(unused)] fn main() { 捲積層1->池化層->捲積層2->池化層->全連接層 (CNN) }

這代表需要建立2個CNN、1個池化層與n個全連接層我們先看到官方說明:

torch.nn.Conv2d(in_channels, out_channels, kernel_size, stride=1, padding=0, dilation=1, groups=1, bias=True, padding_mode='zeros', device=None, dtype=None)

官方文件告訴我們在CNN中需要定義三個參數(in_channels, out_channels, kernel_size),在這之中輸入是唯一需要知道的參數,在CRFAR10資料集中圖片是彩色的,這代表我們的in_channels會是3(RGB),out_channels與kernel_size我們需要通過多次測試與經驗,才能知道最佳的結果,我們可以先隨便設定一個值(這邊先設定out_channels = 6與kernel_size = 5)。

self.conv1 = nn.Conv2d(3, 6, 5)

接下來設定第二層CNN神經網路(上層設定的out_channels是6,所以我們這層的in_channels一定要是6)

self.conv2 = nn.Conv2d(6, 16, 5)

然後我們來看一下池化層的說明:

torch.nn.MaxPool2d(kernel_size, stride=None, padding=0, dilation=1, return_indices=False, ceil_mode=False)

這層是做特徵強化只會縮小圖片大小,所以不會影響到in_channels,所以可以隨意的設定kernel_size

self.pool = nn.MaxPool2d(2, 2)

接下來就會比較困難了,因為要進入到全連接層之前需要將維度攤平,所以我們要先計算最後一層的大小,我們知道輸入的大小是3x32x32的圖像,在經過了第一層CNN之後in_channels = 3 會變成out_channels = 6,那32x32會變成什麼呢?這邊我們就需要套用到CNN參數計算的方式(長或寬 + 2*(padding) - 捲積核) / 步長 + 1,我們將第一層的數據套用到公式裡面(32 + 2*0 - 5) / 1 + 1 = 28(padding預設是0),所以經過第一層後我們的矩陣大小會變成6x28x28,在將矩陣放入池化層中(2x2)得到28/2=14,以此類推。最後會得到16x5x5的結果。

(3*32*32)捲積層1->(6*28*28)池化層->(6*14*14)捲積層2->(16*10*10)池化層->(16*5*5)全連接層(輸出10)

計算完之後就可以設定全連接層的參數

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

#最後輸出要為10(10分類)

self.fc3 = nn.Linear(84, 10)

這樣就建立好神經網路的架構了

def __init__(self):

super().__init__()

#捲積層1

self.conv1 = nn.Conv2d(3, 6, 5)

#捲積層2

self.conv2 = nn.Conv2d(6, 16, 5)

#池化層

self.pool = nn.MaxPool2d(2, 2)

#全連接層

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

接下來要定義這些神經網路的使用方式(攤平資料、激勵函數等計算)

def forward(self, x):

#第一層使用激勵函數relu計算CNN神經網路1後丟給池化層 input(3,32,32) output(6,14,14)

x = self.pool(F.relu(self.conv1(x)))

#第二層使用激勵函數relu計算CNN神經網路2後丟給池化層 input(6,14,14) output(16,5,5)

x = self.pool(F.relu(self.conv2(x)))

#將資料攤平

x = x.view(x.size(0),-1)

#放入全連接層

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

可以看到在pytorch建立神經網路的方式明顯比keras複雜很多,在keras中只需要定義輸入與激勵函數就能輕鬆建立神經網路,而pytorch卻需要計算每層的輸入與輸出,並且還要定義使用的方法,但也因為這樣子的操作更加的自由,使我們能夠做到keras無法做到的事情。

訓練神經網路

終於來到今天的最後一步了,架構好神經網路後當然是要訓練它囉,先來看一下最基本的範例。

for data,label in dataloader:

#將訓練資料放入model裡面做預測

outputs = model(data)

#通過預測結果與label運算損失值

loss = criterion(outputs, label)

#梯度歸0

optimizer.zero_grad()

#反向傳播每個梯度的損失值

loss.backward()

#更新損失值

optimizer.step()

#剛剛建立好的神經網路

model = CNN()

#定義 Loss function

criterion = nn.CrossEntropyLoss()

#定義優化器(模型參數,學習率)

optimizer = optim.adam(model.parameters(), lr=0.001)

這邊有幾個比較重要的資訊optimizer.zero_grad()、loss.backward()、optimizer.step(),

我們知道在深度學習中需要找對最低的梯度,而我們希望每一次訓練的結果是單獨計算的,所以在訓練時常常會看到optimizer.zero_grad()來將梯度初始化,你可能會問pytorch怎麼不直接初始化呢?在訓練神經網路時,有時候希望能持續累積梯度,並通過條件控制梯度的初始化時機,這時如果pytorch把這功能寫死,那可能會導致無法得到預期的效果或是無法訓練神經網路。

loss.backward()、optimizer.step()的概念就比較簡單了,通過設定的loss function做反向傳播(Backpropagation)計算梯度後,通過optimizer.step()將計算出來的loss值交給optimizer做運算,使loss能通過優化器更快速的下降。

接下來為了讓我們知道訓練還需要多久,就可以在剛剛的程式中加入tqdm將進度條顯示出來

#先宣告tqdm的資料

train = tqdm(train_loader)

#更改剛剛的for迴圈

for cnt,(data,label) in enumerate(train, 1):

#訓練

...

#顯示放在前面的文字(通常會放這是第幾次的epoch)

train.set_description(str)

#顯示放在後面的資料(通常會是loss與acc)

# train.set_postfix(dict)

我們也可以在訓練當中切換訓練模式與測試模式。

#訓練模式

model.train()

#測試模式

model.eval()

最後把acc與loss等的計算都加入到程式當中

epochs = 10

#訓練幾次

for epoch in range(epochs):

#訓練資料、loss、準確率

train_loss = 0

train_acc = 0

train = tqdm(train_loader)

#切換成訓練模式

model.train()

#開始訓練

for cnt,(data,label) in enumerate(train, 1):

#將資料放入GPU

data,label = data.cuda() ,label.cuda()

#模型預測

outputs = model(data)

#計算loss

loss = criterion(outputs, label)

#查看模型預測的結果

_,predict_label = torch.max(outputs, 1)

#梯度歸0

optimizer.zero_grad()

#反向傳播後傳給optimizer

loss.backward()

optimizer.step()

#計算當次epoch的loss值

train_loss += loss.item()

#計算當次epoch的acc

train_acc += (predict_label==label).sum()

#顯示

train.set_description(f'train Epoch {epoch}')

train.set_postfix({'loss':float(train_loss)/cnt,'acc': float(train_acc)/cnt})

#切換測試模式

model.eval()

#測試資料、acc

test = tqdm(test_loader)

test_acc = 0

for cnt,(data,label) in enumerate(test, 1):

data,label = data.cuda() ,label.cuda()

outputs = model(data)

_,predict_label = torch.max(outputs, 1)

test_acc += (predict_label==label).sum()

test.set_description(f'test Epoch {epoch}')

test.set_postfix({'acc': float(test_acc)/cnt})

這樣就完成一支pytorch的訓練程式了~

完整程式碼

import os

import torch

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

import torchvision.transforms as transforms

import numpy as np

from cv2 import imread

from torch.utils.data import Dataset, DataLoader

from tqdm import tqdm

class CRFAR10(Dataset):

def __init__(self, path, transform):

self.data = []

for label in os.listdir(path):

for pic in os.listdir(path + '/' + label):

cv_pic = imread(f'{path}/{label}/{pic}')

self.data.append([cv_pic, int(label)])

def __getitem__(self,index):

datas = transform(self.data[index][0])

labels = torch.tensor(self.data[index][1])

return datas, labels

def __len__(self):

return len(self.data)

class CNN(nn.Module):

def __init__(self):

super().__init__()

self.conv1 = nn.Conv2d(3, 6, 5)

self.pool = nn.MaxPool2d(2, 2)

self.conv2 = nn.Conv2d(6, 16, 5)

self.fc1 = nn.Linear(16 * 5 * 5, 120)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

#(輸入 + 2*(padding) - 捲積核) / 移動 + 1

def forward(self, x):

x = self.pool(F.relu(self.conv1(x)))

x = self.pool(F.relu(self.conv2(x)))

x = x.view(x.size(0),-1)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = self.fc3(x)

return x

def train(train_loader,test_loader, model ,optimizer, criterion):

epochs = 10

for epoch in range(epochs):

train_loss = 0

train_acc = 0

train = tqdm(train_loader)

model.train()

for cnt,(data,label) in enumerate(train, 1):

data,label = data.cuda() ,label.cuda()

outputs = model(data)

loss = criterion(outputs, label)

_,predict_label = torch.max(outputs, 1)

optimizer.zero_grad()

loss.backward()

optimizer.step()

train_loss += loss.item()

train_acc += (predict_label==label).sum()

train.set_description(f'train Epoch {epoch}')

train.set_postfix({'loss':float(train_loss)/cnt,'acc': float(train_acc)/cnt})

model.eval()

test = tqdm(test_loader)

test_acc = 0

for cnt,(data,label) in enumerate(test, 1):

data,label = data.cuda() ,label.cuda()

outputs = model(data)

_,predict_label = torch.max(outputs, 1)

test_acc += (predict_label==label).sum()

test.set_description(f'test Epoch {epoch}')

test.set_postfix({'acc': float(test_acc)/cnt})

transform = transforms.Compose([transforms.ToTensor(),

transforms.Normalize((0.5,0.5,0.5),(0.5,0.5,0.5))

])

train_set = CRFAR10(r'pic/train/', transform)

test_set = CRFAR10(r'pic/test/', transform)

train_loader = DataLoader(train_set, batch_size = 128,shuffle = True, num_workers = 0)

test_loader = DataLoader(test_set, batch_size = 128, shuffle = True, num_workers = 0)

model = CNN().cuda()

criterion = nn.CrossEntropyLoss().cuda()

optimizer = optim.SGD(model.parameters(), lr=0.001, momentum=0.9)

train(train_loader, test_loader, model,optimizer,criterion)

今天是不是覺得難度突然上升了很多呢?當我們接觸到pytorch時就會發現,資料集需要學會如何使用class存放資料,建立神經網路需要了解網路構造與運算方式,訓練模型要學會如何使用優化器與損失函數找到最合適的梯度,這些都是keras中沒辦法接觸到的。

今天的課程因為有點複雜,有不懂的地方一定要回去看前面的資料,這樣子才能真正瞭解神經網路的構造與實作方式

讓電腦瞭解文字資料 & 使用Pytorch做IMDB影評分析

讓電腦瞭解文字資料

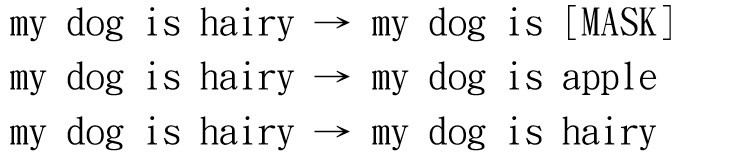

在前幾天的課程中,我們學會如何利用opencv讀取圖片與如何讀取股票資料,像這一些純數值的資料只需要處理矩陣維度後,就能放到神經網路中訓練。如果今天的輸入是文字呢?可能有些人想到了,就是使用在第3天使用到的正規化技術one-hot-encoding。可以將一段文字給予他實際的數字編號後透過one-hot-encoding將資料轉換成機器看得懂的方法。

例如:

#文字

text = I am a student

#給予編號

text_to_int = {I:0, am:1, a:2, student:3}

text = [text_to_int(i) for i in text]

#one-hot-encoding

to_categorical(text)

------------顯示------------

[[1,0,0,0],[0,1,0,0],[0,0,1,0],[0,0,0,1]]

雖然這種方式電腦會看得懂,但會有兩個問題存在,分別是無法辨別一詞多意與資料量太龐大。

先來看以下的例子:

#![allow(unused)] fn main() { It's so cold, I've caught a cold }

我們可以知道第一個cold代表的是寒冷的意思,而第二個cold卻是感冒的意思。若使用one-hot-encoding會把這兩個轉換成相同的list,這代表兩者文字的意思是相同的,這樣訓練效果自然就會很差了。

再來是資料龐大的問題,一個資料集單中假設含有16000個英文單字,那在訓練時一個單字的矩陣大小就會是(1,16000),假設有100字就是(100,16000),光一個100字的文件就足以讓電腦負荷不了,我們昨天實作的圖片一張只有3x32x32,使用這樣的做法訓練一個檔案的時間,就會是昨天訓練大小的520倍!!

所以為了改善這兩個缺點從而衍生了另一種技術詞嵌入(World Embedding),這項技術是目前在自然語言處理(Natural Language Processing)當中最重要的技術,我們甚至可以說,NLP模型基本上就是建立出一個好的embedding結果,那到底什麼是embedding呢?

embedding其實只是一個降維的技術,我們可以將一個數值轉換成embedding的格式例如:

#文字

text = I am a student

#給予編號

text_to_int = {I:0, am:1, a:2, student:3}

text = [text_to_int(i) for i in text]

#假設embedding輸出是768維我們把I丟入

print(embedding(text[0]).shape)

#丟入 I am

print(embedding(text[0:1]).shape)

------------顯示------------

(1,768)

(2,768)

可以看到不管丟入多少個文字,最後輸出都會是(batch, embedding_size),通過embedding_size設定陣列大小,且矩陣內的每一個數值都是float,這代表將會有幾千萬種可能性能夠表達各種單字。再來就是可以通過神經網路訓練embedding層,這樣就能使相似的字或句排列在一起。

實際上是如何做到的呢?假設神經網路架構是使用LSTM,那就會變成使用左邊的文字去預測右邊的文字,或是右邊的文字預測左邊的文字(雙向),通過神經網路學習大量的資料就可以讓神經網路瞭解下一個機率最高的文字是什麼。

IMDB影評分析

接下來進入今天的重點IMDB影評分析。IMDB資料集是一個50000筆電影評論的文本資料集(25000筆訓練25000測試),我們可以通過神經網路的訓練embedding將偏向正面或負面的文字排列在一起,最後通過全連接層完成我們的分類任務

今天的目錄如下:

- 1.函式庫介紹

- 2.資料前處理與創建資料集

- 3.架構神經網路

- 4.訓練神經網路

函式庫介紹

#深度學習函式庫

import torch

#神經元架構與損失函數

import torch.nn as nn

#優化器

import torch.optim as opt

#激勵函數

import torch.nn.functional as F

#創建資料集

from torch.utils.data import Dataset,DataLoader

#系統相關操作

import os

#正規化表達操作

import re

#array操作

import numpy as np

#進度條

from tqdm import tqdm

#切割資料用

import torch.utils.data as data

#excel相關操作

import pandas as pd

資料前處理與創建資料集

在pytorch當創建資料集的方式都大同小異,只差在該如何對資料做前處理,而在NLP中需要經過相當多的資料轉換才能夠放入神經網路做訓練。

首先IMDB的資料集可以使用函式庫輕鬆的取得,但我非常不推薦這一種方式。

# import datasets

from torchtext.datasets import IMDB

train_iter = IMDB(split='train')

def tokenize(label, line):

return line.split()

tokens = []

for label, line in train_iter:

tokens += tokenize(label, line)

原因也很簡單,在訓練自己的資料集時不可能會用到這一個函式庫,若是在練習的時候都是使用這種方式呼叫檔案,那麼就算學會瞭如何架構神經網路與資料集,卻不瞭解這資料的型態與讀取方式就有點本末倒置了。所以在【day7】解析gz檔案 & 使用Pytorch做CIFAR10影像辨識 (上)時教了一些關於解析檔案的技術,藉由這種方式熟悉資料的組成,使程式能夠貼近實際的應用。

不過今天就不先從官方網站下載後解析gz檔開始了(有興趣的可以看我第7天的教學自行解析看看),而是使用CSV檔的方式(NLP的資料大多是CSV檔案),首先我們先到google dataset下載別人解析好的IMDB的影評資料點我下載這樣就可以來進入文字前處理的部分了。

為了不讓不相關的文字影響到我們訓練的效果,所以我們需要先將文字做前處理,我們在IMDB數據集當中有許多的html tag()、單一英文字母(a、b、c)、標點符號(@#$%),我們可以re正規表達式移除這些文字。

def preprocess_text(self,sentence):

#移除html tag

sentence = re.sub(r'<[^>]+>',' ',sentence)

#刪除標點符號與數字

sentence = re.sub('[^a-zA-Z]', ' ', sentence)

#刪除單個英文單字

sentence = re.sub(r"\s+[a-zA-Z]\s+", ' ', sentence)

#刪除多個空格

sentence = re.sub(r'\s+', ' ', sentence)

#轉小寫

return sentence.lower()

在這邊為了方便處理我們將文字多餘的空格刪除掉,只留下最後一個空格當作split()的參數來切割文字,最後再統一文字把文字都轉成小寫。

在NLP中可以把單字叫做令牌(Token)、解析token的東西叫做令牌解析器(Tokenize),我們需要將token通過tokenize轉換成數字才能放入embedding層作訓練,並且需要固定輸入的大小在NLP中最常做的事情就是截長補短,對短的資料作zero padding,所以我們要寫一個能夠找到所有的token後創立tokenize並找到我們文本的最大長度的function。

def get_token2num_maxlen(self, reviews):

token = []

for review in reviews:

#將每筆資料做資料前處理後通過split(' ')把文字存成list

review = self.preprocess_text(review)

token += review.split(' ')

#利用set()回傳一個聯集,並且通過迴圈創建一個文字對應的dict方便轉換

#list(set(token))是包含著我們文本裡面的所有文字資料的聯集

#這邊要注意開頭是1,0通常會作為padding token

token_to_num = {data:cnt for cnt,data in enumerate(list(set(token)),1)}

num = []

max_len = 0

for review in reviews:

review = self.preprocess_text(review)

tmp = []

for token in review.split(' '):

#將文字轉成數字

tmp.append(token_to_num[token])

#找最大值

if len(tmp) > max_len:

max_len = len(tmp)

num.append(tmp)

return num, max_len

接下來我們把程式組合起來後創建我們的資料集

class IMDB(Dataset):

def __init__(self, data):

self.data = []

#讀取文本資料

reviews = data['review'].tolist()

#讀取label

sentiments = data['sentiment'].tolist()

#將文字轉換成數字並且回傳最大文字上限作為padding的根據

reviews, max_len = self.get_token2num_maxlen(reviews)

#GPU不好的可以直接設定數值

#max_len = 500

for review, sentiment in zip(reviews,sentiments):

#防止文字維度大小不同需要做zero padding

if max_len > len(review):

padding_cnt = max_len - len(review)

review += padding_cnt * [0]

else:

review = review[:max_len]

#判斷label

if sentiment == 'positive':

label = 1

else:

label = 0

#創建訓練資料

self.data.append([review,label])

def __getitem__(self,index):

datas = torch.tensor(self.data[index][0])

labels = torch.tensor(self.data[index][1])

return datas, labels

def __len__(self):

return len(self.data)

def preprocess_text(self,sentence):

#移除html tag

sentence = re.sub(r'<[^>]+>',' ',sentence)

#刪除標點符號與數字

sentence = re.sub('[^a-zA-Z]', ' ', sentence)

#刪除單個英文單字

sentence = re.sub(r"\s+[a-zA-Z]\s+", ' ', sentence)

#刪除多個空格

sentence = re.sub(r'\s+', ' ', sentence)

return sentence.lower()

def get_token2num_maxlen(self, reviews):

token = []

for review in reviews:

#將每筆資料做資料前處理後通過split(' ')把文字存成list

review = self.preprocess_text(review)

token += review.split(' ')

#利用set()回傳一個聯集,並且通過迴圈創建一個文字對應的dict方便轉換

#這邊要注意開頭是1,0通常會作為padding token

token_to_num = {data:cnt for cnt,data in enumerate(list(set(token)),1)}

num = []

max_len = 0

for review in reviews:

review = self.preprocess_text(review)

tmp = []

for token in review.split(' '):

#將文字轉成數字

tmp.append(token_to_num[token])

#找最大值

if len(tmp) > max_len:

max_len = len(tmp)

num.append(tmp)

return num,max_len

架構神經網路

今天神經網路的架構如下

#![allow(unused)] fn main() { embedding->LSTM層->全連接層->全連接層1 }

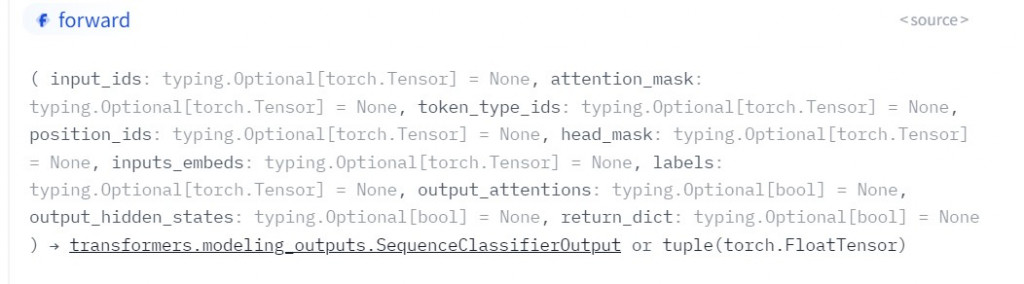

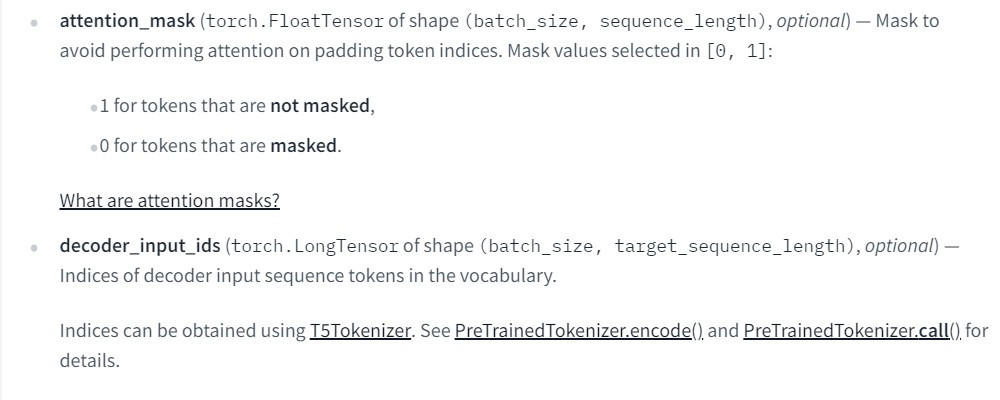

我們先看到embedding的官方敘述

torch.nn.Embedding(num_embeddings, embedding_dim, padding_idx=None, max_norm=None, norm_type=2.0, scale_grad_by_freq=False, sparse=False, _weight=None, device=None, dtype=None)

在這邊只需要輸入兩個參數num_embeddings與embedding_dim,num_embeddings是前面所創立token的大小,embedding_dim則是我們要的輸出大小,這邊要注意embedding_dim太大會導致無法有效的訓練資料,太小則會導致訊息流失。

self.embedding = nn.Embedding(127561, self.embedding_dim)

接下來要了解LSTM層,如果有不太瞭解的地方建議先觀看【day5】爬蟲與股票預測-長短期記憶模型(Long short-term memory) (上)。

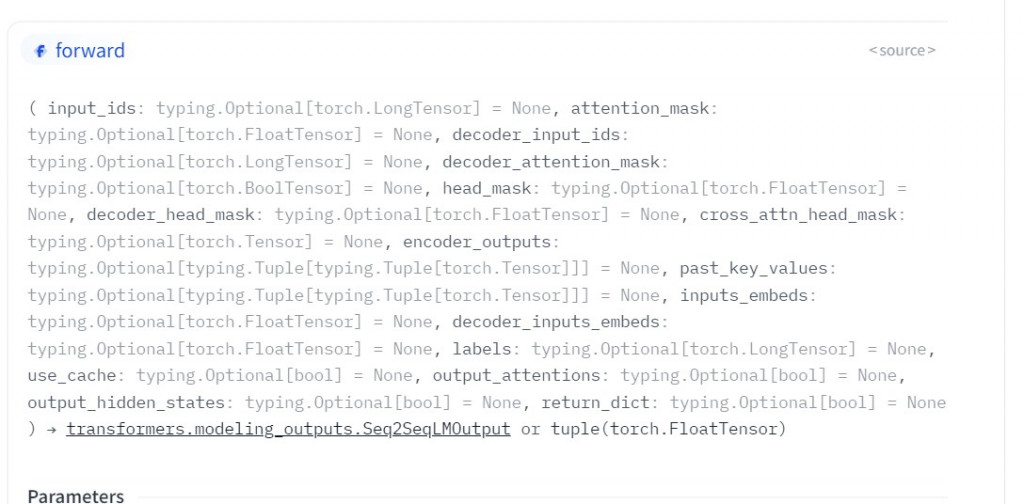

因為LSTM的官方文件有太多東西需要知道了官方文件,

這邊我先整理出來一些參數LSTM(input_size, Hidden_state, Num_layer, Bidirectional=True)接下來我來說明一下這些參數的作用。

Bidirectional:在這一層當中最好理解的參數就是他了,這個參數代表的是神經網路是否為雙向網路,當這個參數為True的時候就能從兩個方向(左到右、右到左)傳遞最後在拼接兩方向的資訊。

Num_layer:在我們第5天的課程內知道LSTM透過H傳遞每一節點的資料,而這個參數就是H的數量,數量的方向非常值觀一個方向為1,兩個方向為2。

Hidden_state:這個參數是指H的大小,若大小太大會影響訓練,太小則會丟失太多資訊

input_size:這個參數在LSTM中是最難理解且最複雜的參數了,我們在第5天提到LSTM每一層的輸入是X與H並通過狀態保存層(C)決定輸出,這在input_size中代表什麼意思呢?這代表我們需要定義X、H、C的維度,因為我們每一個LSTM節點都需要使用到這些,所以input_size在程式中到底長什麼樣子呢?答案就是

((seq_len, batch, input_size), #X

(num_layers * input_size, batch, hidden_size),#H

(num_layers * input_size, batch, hidden_size))#C

在這裡突然一次定義了一大堆的狀態是不是頭都花了呢?現在讓我來把整個架構重新整理一下。

X:首先seq_len就是定義的token大小、batch是資料量大小,input_size則是上層網路的輸出也就是embedding_dim。這跟CNN網路基本上是一樣的道理。 名稱|LSTM | CNN ------------- | ------------- in_channels|seq_len | RGB 資料大小|batch | batch 輸入|上層網路的輸出|上層網路的輸出

H & C:我們知道hidden_state(H)是上一節點的輸出,X是輸入,C是狀態保存層所保留的資訊,這邊快速的定義他們之間的關係。

| 名稱 | 輸入 |

|---|---|

| H | C與X |

| C | H與X |

| X | 上層網路的輸出 |

到這邊我們有沒有發現H與C都需要通過X來計算,所以我們可以知道H與C的輸入,就是X的大小,也就是embedding_dim,而我們的神經是雙向的所以num_layer = 2 ,所以我們會得到輸入大小是2 x embedding_dim。

到這邊是不是瞭解LSTM在幹嘛了,那我們開始架構神經網路吧

def __init__(self, embedding_dim, hidden_size, num_layer):

super().__init__()

#embedding輸出大小

self.embedding_dim = embedding_dim

#hidden_state大小

self.hidden_size = hidden_size

#雙向為2單向為1

self.num_layer = num_layer

#token大小,輸出

self.embedding = nn.Embedding(127561, self.embedding_dim)

#上層輸入大小,hidden state大小,單為1雙為2,單向還是雙向

self.lstm =nn.LSTM(self.embedding_dim, self.hidden_size, self.num_layer, bidirectional = True)

#最後輸出的結果為最後一個狀態的hidden_size * num_layer * 2為最後一個為度長度

self.fc = nn.Linear(hidden_size * self.num_layer * 2, 20)

self.fc1 = nn.Linear(20, 2)

def forward(self, x):

#將文字降維

x = self.embedding(x)

#此時狀態為(batch_size, token大小, embedding_dim)我們需要將他轉成LSTM格式

x = x.permute([1,0,2])

#(token大小,batch_size,embedding_dim)

states, hidden = self.lstm(x, None)#H跟C設定成0

#因為是雙向網路所以需要找到從左到右(最後一筆資料)的狀態與從右到左(第一筆資料)

x = torch.cat((states[0], states[-1]), 1)

#全連接層

x = F.relu(self.fc(x))

x = F.relu(self.fc1(x))

#二分法所以使用sigmoid

x = F.sigmoid(x)

return x

訓練神經網路

終於到這一步了,今天在這步驟完全跟昨天的方式一樣我們直接複製貼上就好

def train(train_loader,test_loader, model ,optimizer, criterion):

epochs = 10

for epoch in range(epochs):

train_loss = 0

train_acc = 0

train = tqdm(train_loader)

model.train()

for cnt,(data,label) in enumerate(train, 1):

data,label = data.cuda() ,label.cuda()

outputs = model(data)

loss = criterion(outputs, label)

_,predict_label = torch.max(outputs, 1)

optimizer.zero_grad()

loss.backward()

optimizer.step()

train_loss += loss.item()

train_acc += (predict_label==label).sum()

train.set_description(f'train Epoch {epoch}')

train.set_postfix({'loss':float(train_loss)/cnt,'acc': float(train_acc)/cnt})

model.eval()

test = tqdm(test_loader)

test_acc = 0

for cnt,(data,label) in enumerate(test, 1):

data,label = data.cuda() ,label.cuda()

outputs = model(data)

_,predict_label = torch.max(outputs, 1)

test_acc += (predict_label==label).sum()

test.set_description(f'test Epoch {epoch}

-------------------------------------------顯示-------------------------------------------

train Epoch 4: 100%|████████████████████████████████████████████| 313/313 [00:18<00:00, 17.03it/s, loss=0.533, acc=95.1]

test Epoch 4: 100%|██████████████████████████████████████████████████████████| 79/79 [00:01<00:00, 73.57it/s, acc=93.2]

完整程式碼

import torch

import torch.nn as nn

import torch.optim as opt

import torch.nn.functional as F

from torch.utils.data import Dataset,DataLoader

import os

import re

import numpy as np

from tqdm import tqdm

import torch.utils.data as data

import pandas as pd

os.environ['CUDA_LAUNCH_BLOCKING'] = "1"

class IMDB(Dataset):

def __init__(self, data, max_len =500):

self.data = []

reviews = data['review'].tolist()

sentiments = data['sentiment'].tolist()

reviews, max_len = self.get_token2num_maxlen(reviews)

max_len = 500

for review, sentiment in zip(reviews,sentiments):

if max_len > len(review):

padding_cnt = max_len - len(review)

review += padding_cnt * [0]

else:

review = review[:max_len]

if sentiment == 'positive':

label = 1

else:

label = 0

self.data.append([review,label])

def __getitem__(self,index):

datas = torch.tensor(self.data[index][0])

labels = torch.tensor(self.data[index][1])

return datas, labels

def __len__(self):

return len(self.data)

def preprocess_text(self,sentence):

#移除html tag

sentence = re.sub(r'<[^>]+>',' ',sentence)

#刪除標點符號與數字

sentence = re.sub('[^a-zA-Z]', ' ', sentence)

#刪除單個英文單字

sentence = re.sub(r"\s+[a-zA-Z]\s+", ' ', sentence)

#刪除多個空格

sentence = re.sub(r'\s+', ' ', sentence)

return sentence.lower()

def get_token2num_maxlen(self, reviews,enable=True):

token = []

for review in reviews:

review = self.preprocess_text(review)

token += review.split(' ')

token_to_num = {data:cnt for cnt,data in enumerate(list(set(token)),1)}

num = []

max_len = 0

for review in reviews:

review = self.preprocess_text(review)

tmp = []

for token in review.split(' '):

tmp.append(token_to_num[token])

if len(tmp) > max_len:

max_len = len(tmp)

num.append(tmp)

return num, max_len

class RNN(nn.Module):

def __init__(self, embedding_dim, hidden_size, num_layer):

super().__init__()

self.embedding_dim = embedding_dim

self.hidden_size = hidden_size

self.num_layer = num_layer

self.embedding = nn.Embedding(127561, self.embedding_dim)

self.lstm =nn.LSTM(self.embedding_dim, self.hidden_size, self.num_layer, bidirectional = True)

self.fc = nn.Linear(hidden_size * 4, 20)

self.fc1 = nn.Linear(20, 2)

def forward(self, x):

x = self.embedding(x)

states, hidden = self.lstm(x.permute([1,0,2]), None)

x = torch.cat((states[0], states[-1]), 1)

x = F.relu(self.fc(x))

x = F.relu(self.fc1(x))

x = F.sigmoid(x)

return x

def train(train_loader,test_loader, model ,optimizer, criterion):

epochs = 10

for epoch in range(epochs):

train_loss = 0

train_acc = 0

train = tqdm(train_loader)

model.train()

for cnt,(data,label) in enumerate(train, 1):

data,label = data.cuda() ,label.cuda()

outputs = model(data)

loss = criterion(outputs, label)

_,predict_label = torch.max(outputs, 1)

optimizer.zero_grad()

loss.backward()

optimizer.step()

train_loss += loss.item()

train_acc += (predict_label==label).sum()

train.set_description(f'train Epoch {epoch}')

train.set_postfix({'loss':float(train_loss)/cnt,'acc': float(train_acc)/cnt})

model.eval()

test = tqdm(test_loader)

test_acc = 0

for cnt,(data,label) in enumerate(test, 1):

data,label = data.cuda() ,label.cuda()

outputs = model(data)

_,predict_label = torch.max(outputs, 1)

test_acc += (predict_label==label).sum()

test.set_description(f'test Epoch {epoch}')

test.set_postfix({'acc': float(test_acc)/cnt})

df = pd.read_csv('IMDB Dataset.csv')

dataset = IMDB(df)

train_set_size = int(len(dataset)*0.8)

test_set_size = len(dataset) - train_set_size

train_set, test_set = data.random_split(dataset, [train_set_size, test_set_size])

train_loader = DataLoader(train_set, batch_size = 128,shuffle = True, num_workers = 0)

test_loader = DataLoader(test_set, batch_size = 128, shuffle = True, num_workers = 0)

model = RNN(embedding_dim = 256, hidden_size = 64, num_layer = 2).cuda()

optimizer = opt.Adam(model.parameters())

criterion = nn.CrossEntropyLoss()

train(train_loader, test_loader, model,optimizer,criterion)

這幾天有沒有感覺到資訊量越來越多了,這幾天的pytorch內容盡量反覆閱讀與實作才能夠真正瞭解網路架構,所以我們明天就來學一些簡單東西來休息一下吧

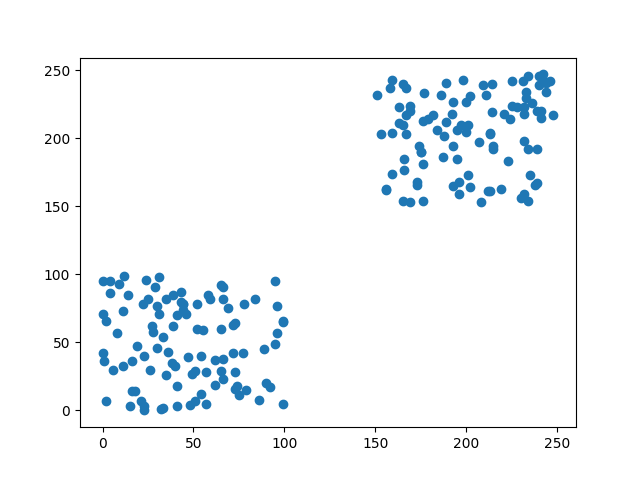

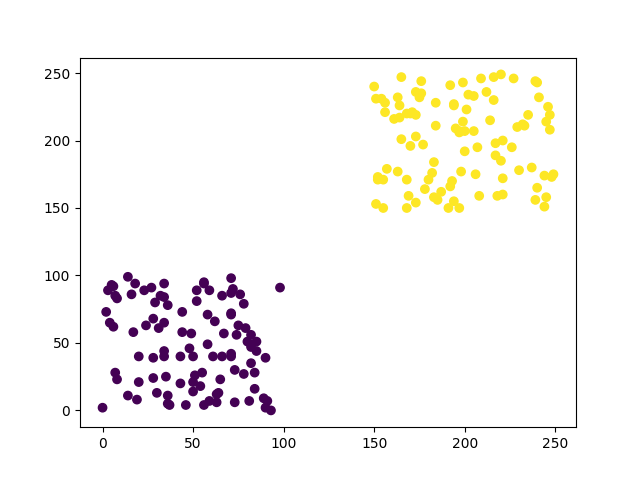

人工智慧、機器學習、深度學習究竟差異在哪裡?

人工智慧、機器學習、深度學習

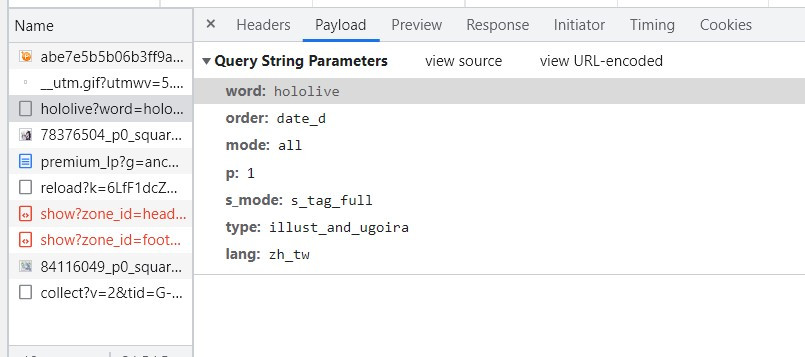

來源:https://www.logicmonitor.com/blog/troubleshoot-faster-with-anomaly-visualization

在這張圖片我可以知道我們所說的AI其實包含者許許多多的技術,像是機器學習(Machine Learning)就是AI裡面的其中一個分支,在機械學習中深度學習((Deep Learning)又是另一個分支,那麼他們的差異在哪呢?

人工智慧(Artificial Intelligence)

在這邊AI的定義是人製造出來的機器所能表現出來的智慧都能夠稱之為AI,那該怎麼知道程式有沒有智慧呢?在1950年,圖靈提出了一個叫做圖靈測試(Turing test)實驗,這個實驗的內容非常的簡單,如果一個人(A)詢問這個機器人問題,但回答方一個是由真人(B),另一個則是電腦(C),並經過多輪的實驗,看A能不能每次都正確判斷B與C,只要A沒辦法分辨出來,那我們就可以說C是一種AI技術。

那撇除掉深度學習與機器學習這裡的AI還有什麼技術呢?在這邊比較有名的就是專家系統(Expert System),這項技術的核心其實就是資料庫加上推理機(Inference Engine),通過推理的資料庫中的路線找到最合適的解答。

ex:創建某個疾病的常見回答資料庫,並通過推理找到最合適的答案。

機器學習(Machine Learning)

機器學習是人工智慧的分支之一那麼差別在哪呢?剛剛提到的專家系統需要靠者許多專家建立資料,花費太多人力與時間,而在機器學習的領域中就能改善這項問題,因為機器學習最重要的技術就是讓機器可自主學習。

這裡讓機器學習的方式分成以下4種監督學習(Supervised Learning)、非監督學習(Unsupervised Learning)、半監督學習(Semi-supervised Learning)與強化學習(Reinforcement Learning)。

監督學習(Supervised Learning)

監督式學習的資料集是由輸入資料和人工標註物件出所組成的,通過資料集建立模式(learning model),在觀察完一些先前標記過的訓練範例(輸入資料和人工標註物件出)後,去預測這個模式可能出現的輸入與輸出,在機器學習中常見的有KNN演算法、SVM。

目前這種學習的方式基本用於深度學習的迴歸(Regression)任務與分類(classifier)任務中,像是之前實作的迴歸任務的股票預測,以及分類任務的IMDB影評情感分析、CRIFT10影像辨識、MNIST手寫辨識都是屬於監督學習。

非監督學習(Unsupervised Learning)

非監督學習與監督學習差別在於沒有預期輸出(也就是人工標註的物件),這種學習方式,會透過演算法將自行尋找出資料的規律,在機器學習中經常會用在把資料分群(clustering )上。

而非監督學習在深度學習中在我們的日常生活中就有很多案例了,例如:IG與抖音上的濾鏡、贏得美術比賽的AI繪圖軟體Midjourney、日本推特上引發熱門議題的仿畫繪圖工具Mimic都是屬於非監督是學習訓練出來的結果。

半監督學習(Semi-supervised Learning)

半監督學習的方式比較特殊,他與監督學習很相似,只差在我們資料的label並不是完整的,例如我們的資料集中只有100筆有標註,但卻有1000筆資料,這種訓練方式就會特過100筆的資訊推測並訓練其他900張圖片的結果最常見的技術就是生成任務。

強化學習(Reinforcement learning)

這種學習方式就與先前的三種不同了,這種學習方式會透過與電腦互動的方式不斷的計算,來達到最終設定的目標,簡單來說就是我每做出一個動作前,電腦就會計算出我的下一步分數是最高的,並且通過動態的方式不斷的改變這些分數,像是幾年前引發議題的AlphaGo就是以這種方式訓練出來的。

深度學習

我們剛剛可以看到在機械學習中講到了許多深度學習的內容,因為深度學習是機械學習的分支,所以機械學習中的概念大多能套用至深度學習,而兩者最大的差異就在於是不是能自動找到特徵與神經網路層。

在深度學習中我們只需要設定好各神經網路參數就能通過訓練自動截取特徵,並且通過不同神經網路的演算法找到一個最佳的結果,但機械學習中我們卻需要自行找到特徵,在把這個特徵放入的單一的演算法當中。

結論

今天看完了這些知識有沒有注意到,深度學習只是在AI這領域的一小部分,且我們在日常生活中也能看到這些模型的應用(車牌辨識、google翻譯、人臉辨識、物件檢測...等),而且在AI比賽當中有時取得最佳成績的是機器學習的方式,所以我們明天來看一些機器學習的技術吧。

集成式學習 & 使用xgboost過濾垃圾郵件

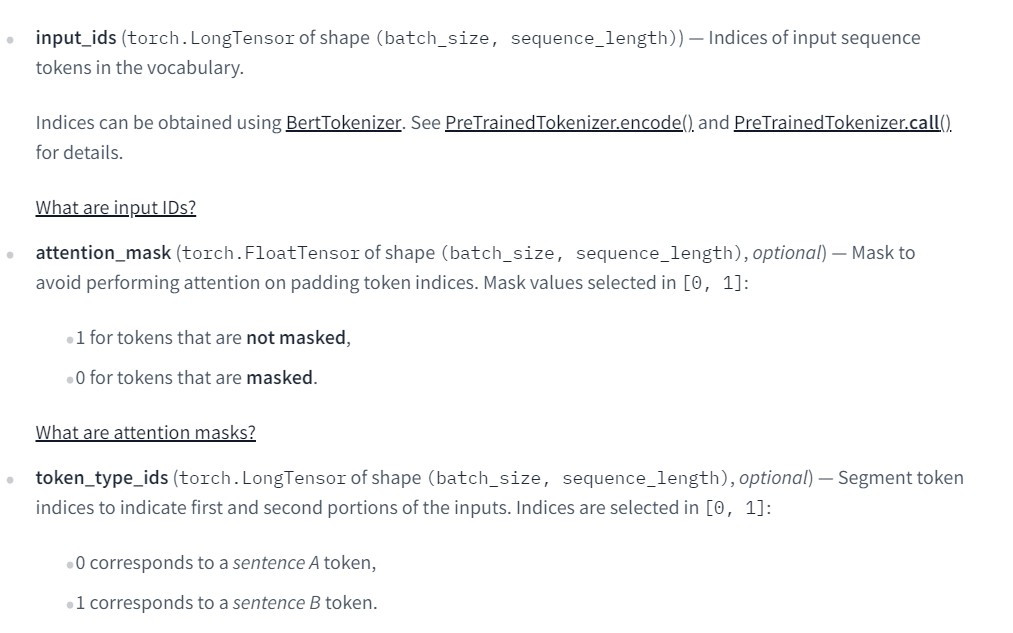

集成式學習(Ensemble learning)

集成式學習(Ensemble learning)是一種機器學習的學習方式,這種學習方式是將好幾個監督式學習的模型結合在一起,來獲得比使用單獨學習算法更好的效果。我們可以將它這學習方式分成三類,分別是引導聚集算法(Bagging),提升方法(Boosting),堆疊法(Stacking)。

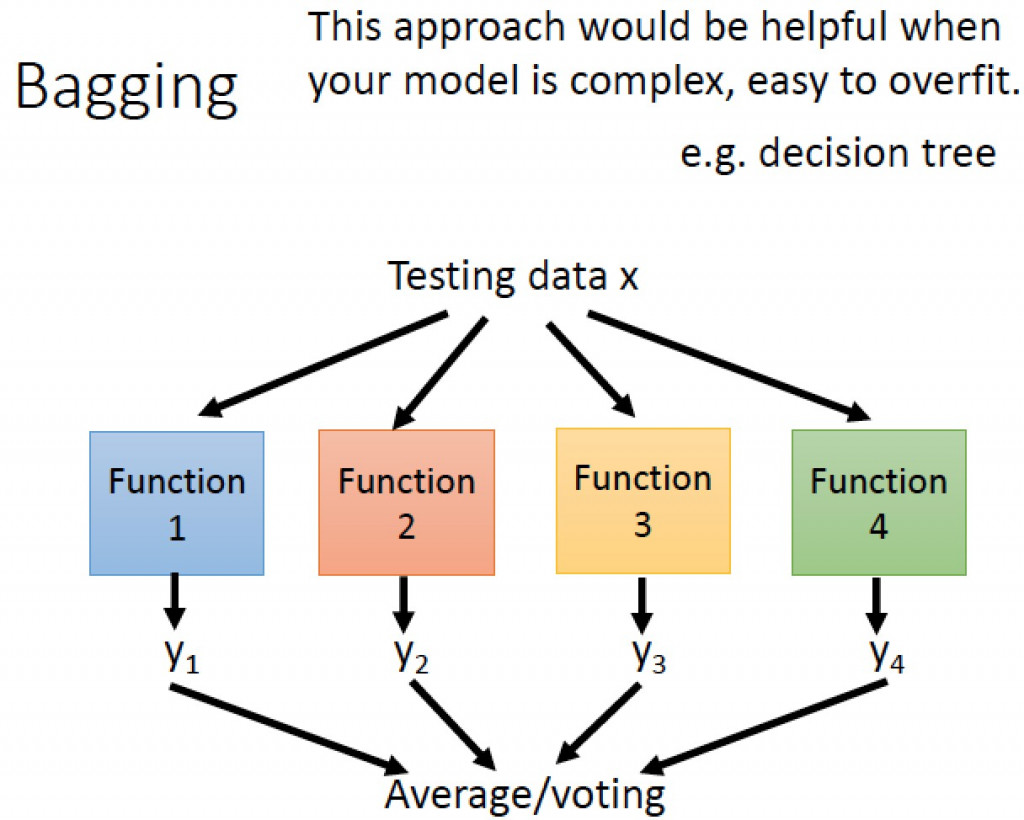

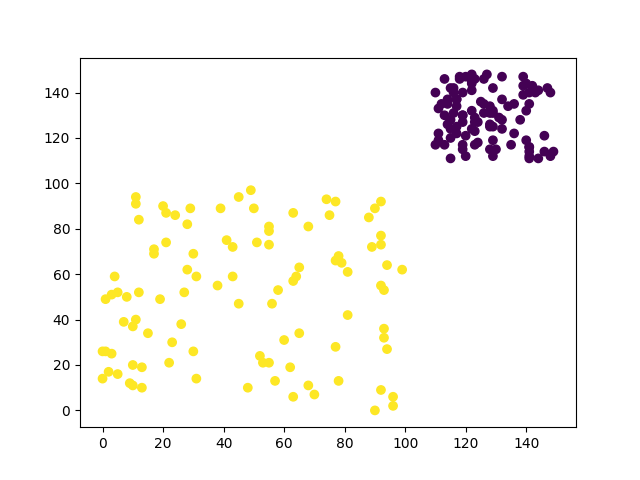

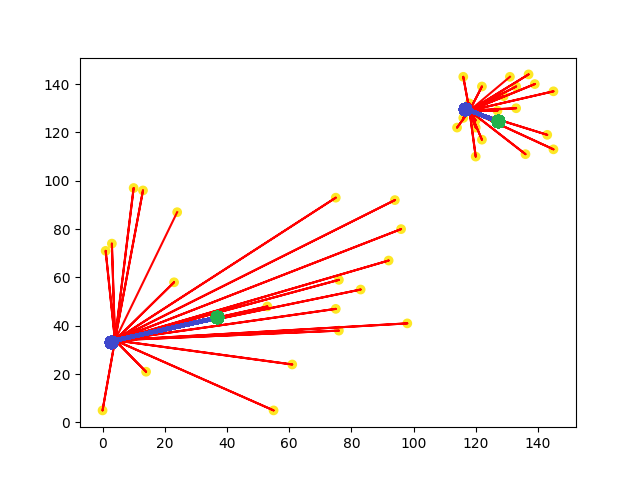

引導聚集算法(Bagging)

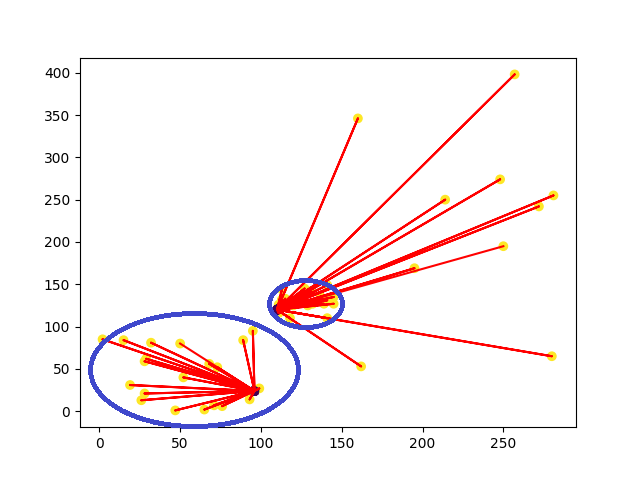

圖片來源:李弘毅老師youtube影片

引導聚集算法(Bagging)模型是基於統計學中的自助法(Bootstrapping)來實現的,這種算法是將資料集隨機抽樣建立類群後,在重新抽取下一個類群,不斷的重複這個過程後,訓練每個類群的結果拿來做整合,如果是迴歸任務,則會做平均。舉一個例子來說:我們從一個球池裡面隨機抽取幾個球並記錄裡面球的特徵,之後在放回球池當中,在繼續重複這樣的動作,最後統計每一個類群裡球的特徵找到最好的結果,常見的例子有隨機森林(Random Forest)與決策樹(Decision Tree)。

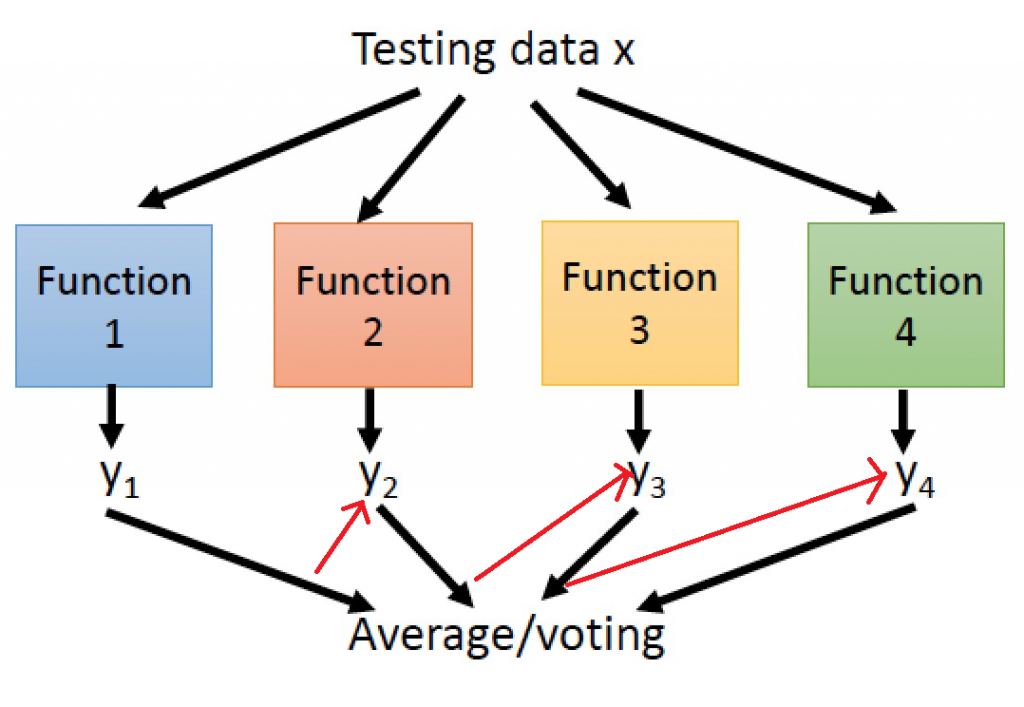

提升方法(Boosting)

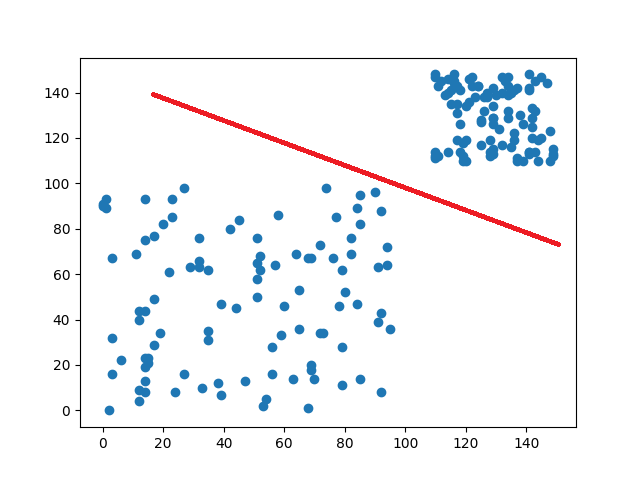

提升方法(Boosting)主要用來減小監督式學習中偏差與方差,一樣會先隨機抽取資料並分類,並通過迭代學習去計算這次模型的誤差(圖片中的紅色箭頭),之後更新每個樣本被抽到的機率,若前一次分類錯誤率愈高,則權重愈大,最終將每次迭代的結果一起計算,常見的例子

提升方法(Boosting)主要用來減小監督式學習中偏差與方差,一樣會先隨機抽取資料並分類,並通過迭代學習去計算這次模型的誤差(圖片中的紅色箭頭),之後更新每個樣本被抽到的機率,若前一次分類錯誤率愈高,則權重愈大,最終將每次迭代的結果一起計算,常見的例子極限梯度下降(Xgboost)、自適應增強(adaboost)。

堆疊法(Stacking)

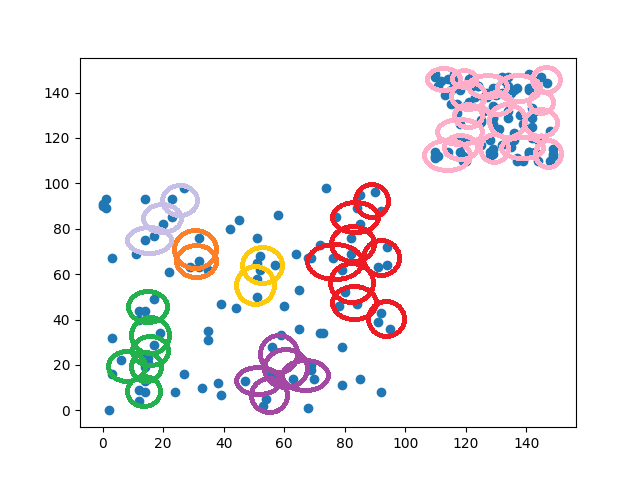

圖片來源:https://www.geeksforgeeks.org/stacking-in-machine-learning-2/

堆疊法(Stacking)與引導聚集算法非常的相似,只差在一個是訓練部分資料,一個是訓練全部的資料,意思就是堆疊法訓練出獨立模型,當作最終模型的輸入特徵,並且訓練這個最終模型,藉由這種方式補足某個模型中缺失的資訊,增強迷型的效果。

過濾垃圾郵件

今天的目錄如下: 1.安裝函式庫與建立基本環境 2.資料前處理 3.訓練模型 4.測試與比較

安裝函式庫與建立基本環境

安裝函式庫

pip install xgboost

引用函式庫

import pandas as pd

import numpy as np

import random

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.ensemble import RandomForestClassifier

from xgboost import XGBClassifier

from sklearn.tree import DecisionTreeClassifier

導入資料集

今天的資料集是SMSSpamCollection點我下載,這個資料集包含者垃圾郵件與真實有用的文件,今天要做的事就是抽取個文件的特徵與分類。我們先利用pandas讀取資料後在開始做資料前處理吧

data = pd.read_csv('SMSSpamCollection.csv')

資料前處理

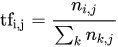

還記得我說過機器學習與深度學習差距究竟在哪嗎?沒錯就是特徵抽取(Feature extraction)的部分,所以我們在資料處理時就需要加入這一個步驟,而在文本中有一個非常好用的技術叫做TF-IDF(Term Frequency-Inverse Document Frequency),這個技術分成兩個部分詞頻(Term Frequecny)與逆向文件頻率(Inverse Document Frequency)。

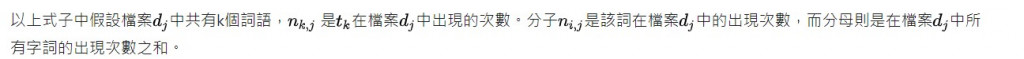

我們來先看一下TF(詞頻)的公式計算

來源:https://zh.m.wikipedia.org/zh-tw/Tf-idf

在維基百科中是這樣解釋這個公式的

這樣是不是有一點複雜?其實TF的概念就是出現在文本中的次數越多次,代表這個單字越沒有獨特性所以計算起來的分數越低。所以這公式的的意思其實就是

這樣是不是有一點複雜?其實TF的概念就是出現在文本中的次數越多次,代表這個單字越沒有獨特性所以計算起來的分數越低。所以這公式的的意思其實就是文字/文字在"單一文件"出現的次數。

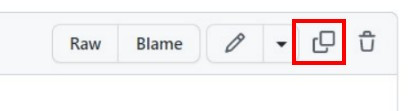

那IDF(逆向文件頻率)是什麼呢?從名稱中可以瞭解他是一種反向的詞頻計算方式,他的概念與TF相反,在全部的文件中文字出現的越少,代表這文字該資料中是越有獨特性的。

https://zh.m.wikipedia.org/zh-tw/Tf-idf

所以這公式又能解讀成

log10(文字/文字出現在"全部文件"次數)

為了使我們的資料能夠使用TF-IDF這項技術,所以我們需要先分類出垃圾郵件與真實使用到的郵件。

def classfier(data):

real, fake = [], []

for text, label in zip(data['sms'].values, data['class'].values):

if label == 'spam':

#記得將文字轉小寫

fake.append(text.lower())

else:

real.append(text.lower())

return fake,real

再來透過sklearn計算出這兩個文件TF-IDF分數,但在這邊要注意回傳的結果並不會是有順序的排列,所以我們還需要再另外寫一個function做氣泡序法(Bubble Sort),將數值從大到小排列出來方便我們取用。

def getTopScore(data,text):

n = len(data)

while n > 1:

n-=1

for i in range(n):

#若右側資料比左邊大就交換

if data[i] < data[i+1]:

#文字

text[i], text[i+1] = text[i+1], text[i]

#數值

data[i], data[i+1] = data[i+1], data[i]

return text

之後就能用計算TF-IDF分數,並使用剛剛建立的function創建前200分數最高的文字,作為資料的特徵。

def getTfIdfText(fake,real,max_val = 200):

#宣告變數

vectorizer = TfidfVectorizer()

#計算TF-IDF

X = vectorizer.fit_transform([' '.join(fake),' '.join(real)]).toarray()

#計算分數最高的文字

fake_text_top = getTopScore(X[0],vectorizer.get_feature_names())

real_text_top = getTopScore(X[1],vectorizer.get_feature_names())

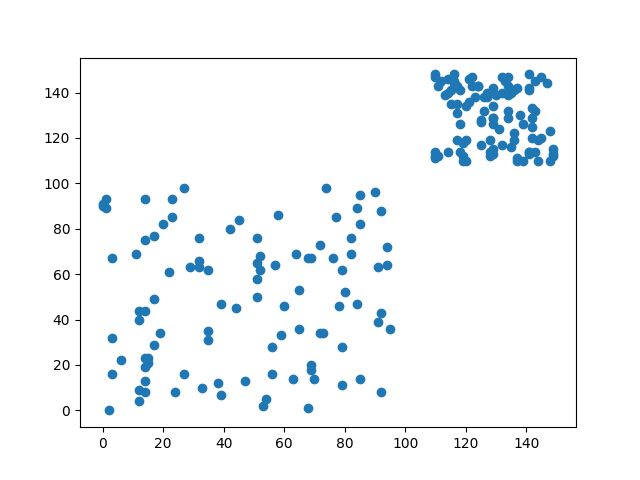

#回傳指定的最大結果

return fake_text_top[:max_val],real_text_top[:max_val]

接下來我們通過這200個字將我們的原始資料轉換成數字的格式,若是數字有出現我們就設定2,若沒有出現那就設定成1,若超過範圍我們就做zero padding。

def text2num(data, top):

result = []

for i in data:

tmp = []

for j in i.split(' '):

if j in top:

tmp.append(2)

else:

tmp.append(1)

if len(tmp)<80:

tmp = tmp + (80-len(tmp))*[0]

else:

tmp = tmp[:80]

result.append(tmp)

tmp = []

return result

接下來需要將資料拆分成測試數據與訓練數據來驗證程式的準確率,為了讓資料平均分佈我們要先將真實郵件與垃圾郵件分別依照比例分割。

def splitData(data, split_rate=0.8):

cnt = int(len(data)*split_rate)

train_data=data[:cnt]

test_data =data[cnt:]

return train_data,test_data

f_train,f_test = splitData(fake_data)

r_train,r_test = splitData(real_data)

並將分割的數據組合起來並給予他們label,且需要打亂資料以免造成overfitting(前面學到的都是0後面學到都是1) def randomShuffle(x_batch,y_batch,seed=100): random.seed(seed) random.shuffle(x_batch) random.seed(seed) random.shuffle(y_batch)

return x_batch,y_batch

train_data,train_label = randomShuffle(f_train+r_train,[0 for i in range(len(f_train))]+[1 for i in range(len(r_train))]) test_data,test_label = randomShuffle(f_test + r_test,[0 for i in range(len(f_test))]+[1 for i in range(len(r_test))])

這樣就完成資料前處理了

測試與比較

首先我們先使用決策樹、亂數森林與極限梯度下降法這三個機器學習模型訓練。

我們先快速的建立一下訓練的function

def train(train_data,train_label):

#決策樹模型

model_tree = DecisionTreeClassifier(criterion = 'entropy', max_depth=6, random_state=42)

#訓練

model_tree.fit(train_data, train_label)

#預測結果

y_hat_tree = model_tree.predict(train_data)

#亂樹森林模型

model_RF = RandomForestClassifier(n_estimators=10, max_depth=None,min_samples_split=2, random_state=0)

#訓練

model_RF.fit(train_data, train_label)

#預測結果

Y_hat_RF = model_RF.predict(train_data)

#極限梯度下降法模型

model_xgboost = XGBClassifier(n_estimators=100, learning_rate= 0.3)

#訓練

model_xgboost.fit(train_data, train_label)

#預測結果

Y_hat_xg = model_xgboost.predict(train_data)

#找到label大小作為準確率的分母

n=np.size(train_label)

#顯示機率

print('Accuarcy decisionTree: {:.2f}%'.format(sum(np.int_(y_hat_tree==train_label))*100./n))

print('Accuarcy RandomForest: {:.2f}%'.format(sum(np.int_(Y_hat_RF==train_label))*100./n))

print('Accuarcy XgBoost: {:.2f}%'.format(sum(np.int_(predicted==train_label))*100./n))

在這邊可以看到,在機器學習中建立模型的方式非常的簡單,只需要三步驟:宣告、訓練、看結果,就能完成訓練,且速度與深度學習相比快了好幾倍,因為我們只是通過公式的運算,而不是訓練神經網路,那我們來看一下最後訓練的結果。

訓練:

Accuarcy decisionTree: 88.31%

Accuarcy RandomForest: 99.42%

Accuarcy XgBoost: 98.95%

測試:

Accuarcy decisionTree: 88.98%

Accuarcy RandomForest: 99.46%

Accuarcy XgBoost: 99.46%

我們可以看到決策樹的效果相當的不好,最大的原因就是他每次規劃的路徑都是相同的這代表我們使用決策樹,最後的結果一定會overfitting。而亂樹森林則是以決策樹的方式加以改良,使用隨機抽取資料的方式,大幅增進最終的運算結果。今天的重頭戲xgoost可以看到在訓時準確率較低,但測試數據的準確率卻與亂樹森林相同,這是因我們們的資料比較單調以及數量較少的原因,若今天資料量較多xgboost能夠跌代計算出來的結果就會越準確,那差距就會與亂樹森林以及決策樹更大了。

預訓練模型訓練 & 應用- 使用OpenCV製作人臉辨識點名系統 (上)

到這邊我相信你已經有機器學習與深度學習的概念了,所以接下來的課程中我會開始來教一些預訓練模型的用法,而這次要做的就是使用OPENCV辨識人臉並成功點名,而我們今天要做的事情就是辨識臉部並創建自己的資料集。

辨識臉部

今天的目錄如下

- 1.開啟電腦鏡頭並顯示

- 2.下載xml與辨識臉部

- 3.減少電腦資源與可視化

開啟電腦鏡頭並顯示

在開始辨識人臉之前我們需要打開電腦鏡頭,這裡可以使用opencv當中VideoCaptured()開啟鏡頭,但在windows當中卻有一些BUG存在,就是無法每次都成功的開啟,所以我們可以寫一個while迴圈,判斷鏡頭是否開啟,來解決這個問題。

#開啟鏡頭

cap = cv2.VideoCapture(0)

#確保鏡頭完整的開啟

while(not cap.isOpened()):

cap = cv2.VideoCapture(0)

開啟鏡頭後,就能開始讀取資料了,透過cap.read()能讀取目前鏡頭的照片。

#是否有圖片type:bool,圖片本身

ret, frame = cap.read()

但在市面上的人臉辨識系統,都是以影片的樣式來表達,所以我們需要利用肉眼視覺暫留(Persistence of vision)的方式將圖片轉成影片,所以我們要將cap.read()這個function放入到while()當中進行迴圈,最後通過imshow將結果顯示出來,並且能夠使用imwrite來儲存圖片()

cnt = 0

while(True):

ret, frame = cap.read()

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

cv2.imshow('live', frame)

cv2.imwrite(f'face/my_face_{cnt}.jpg',frame)

這樣我們就可以取得很多的人臉圖片

但我們觀察這張圖片就會發現,照片中含有太多的不是人臉的資料,這樣在訓練時可能就會使準確率下降,甚至是underfitting,所以這時就需要使用opencv的臉部辨識器,來找到我們的人臉。

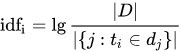

下載xml與辨識臉部

首先我們前往opencv的github找到"haarcascade_frontalface_alt2.xml"點我前往

之後點擊紅框處複製文字

最後貼上記事本上並將檔案名稱命名為"haarcascade_frontalface_alt2.xml",這樣我們就有臉部辨識的設定檔了

我們剛剛下載的是程式設定檔,所以還需加入模型本身,在這邊只需要使用CascadeClassifier()就能建立一個臉部辨識器了。

classfier = cv2.CascadeClassifier(cv2.data.haarcascades +"haarcascade_frontalface_alt2.xml")

減少電腦資源與可視化

有了辨識器後我們需要去設定他的參數我們先看個範例

faceRects = classfier.detectMultiScale(gray, scaleFactor = 1.2, minNeighbors = 3, minSize = (32, 32))

首先說明一下這些參數的意思

ScaleFactor:每次搜尋方塊減少的比例

minNeighbors:矩形個數

minSize:檢測對象最小值

這樣是不是還是看不懂?因為opencv中是使用一種叫做蒙地卡羅方法(Monte Carlo method)的方式,這種方法的中心技術就是猜與賭,這種做法就像是捕魚一樣,我們先灑網出去猜這個區域究竟有沒有魚,若是有魚我們就開始縮小魚網的範圍,最後把魚抓上來。

我們來看看在opencv中會使用哪些做法,首先使用較大範圍的方格去辨識臉部,在opencv中是使minNeighbors這個參數是來辨別相鄰方格的關聯性,關聯性大於等於這個值時電腦才認為區域內有臉部。若區域內有臉部會透過ScaleFactor數值減少範圍大小,直到指定的最小範圍時minSize時縮小才會停止,而使用這種技術可使減少消耗電腦的資源,畢竟圖像資源是非常吃效能的。

瞭解後我們會知道,圖片會有機會找不到人臉,這時程式正在擴大範圍在偵測,此時會消耗非常多的效能,若是在繼續執行動作可能會導致程式出現意外狀況,所以我們需要設定成當有人臉時才繼續接續的動作。

if faceRects:

當條件達成後代表faceRects裡面含有4個數值分別是x軸座標、y軸座標、寬、長,但可能不只讀到一張人臉,所以需要將程式寫在一個for迴圈中找到所有的人臉數值

for (x, y, w, h) in faceRects:

有了這些數值後我們能通過縮小圖片的範圍,並且畫出一個方形包住我們的人臉,代表程式有偵測到

face = frame[y - 10: y + h + 10, x - 10: x + w + 10]

#圖片,座標,長寬,線條顏色,粗度

cv2.rectangle(frame, (x - 10, y - 10), (x + w + 10, y + h + 10), (0,255,0), 2)

為了增加辨識臉部的準確率先將資料轉換成灰階,這可以使小區域的亮度降低防止單一像素過亮的問題,這種做法並不會改變圖片整體的亮度。

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

我們的程式是寫在一個while迴圈中,所以我們要設定一個跳脫條件,我們可以設定成按Q件離開,並且在離開後需要將視窗與鏡頭都一起關閉。

#按Q跳脫迴圈

if cv2.waitKey(1) == ord('q'):

break

#釋放鏡頭

cap.release()

#關閉視窗

cv2.destroyAllWindows()

最後將程式碼組合在一起就完成取得人臉的方式了

完整程式碼

import cv2

cap = cv2.VideoCapture(0)

while(not cap.isOpened()):

cap = cv2.VideoCapture(0)

cnt = 0

classfier = cv2.CascadeClassifier(cv2.data.haarcascades +"haarcascade_frontalface_alt2.xml")

while(True):

ret, frame = cap.read()

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

faceRects = classfier.detectMultiScale(gray, scaleFactor = 1.2, minNeighbors = 3, minSize = (32, 32))

if len(faceRects) > 0:

for (x, y, w, h) in faceRects:

face = frame[y - 10: y + h + 10, x - 10: x + w + 10]

c

cnt+=1

cv2.imwrite(f'face/my_face_{cnt}.jpg',face)

if cv2.waitKey(1) == ord('q'):

break

cv2.imshow('live', frame)

cap.release()

cv2.destroyAllWindows()

今天的難度是不是變成比較低了呢?因為今天只是在玩一些opencv的套件,明天的難度會開始提升,因為會來玩一下預訓練模型VGG-16

預訓練模型訓練 & 應用- 使用OpenCV製作人臉辨識點名系統 (下)

還記得我們在使用LSTM或是CNN時都需要創建Data與Label並花費一些時間訓練我們的神經網路嗎?我相信在訓練神經網路時是會花費相當多的時間的,我們在訓練的這些資料可能只有5萬筆訓練完的時間大約1分鐘左右就可以完成。但如果我們所訓練的資料是幾百萬或幾千萬呢?那就算是3090ti訓練一個月都還跑不完,若我們很需要這一些的訓練的結果呢?那就只能去找看看有沒有人有相似的模型來修改,所以這時就有遷移學習(Transfer Learning)這種方式來幫助我們。

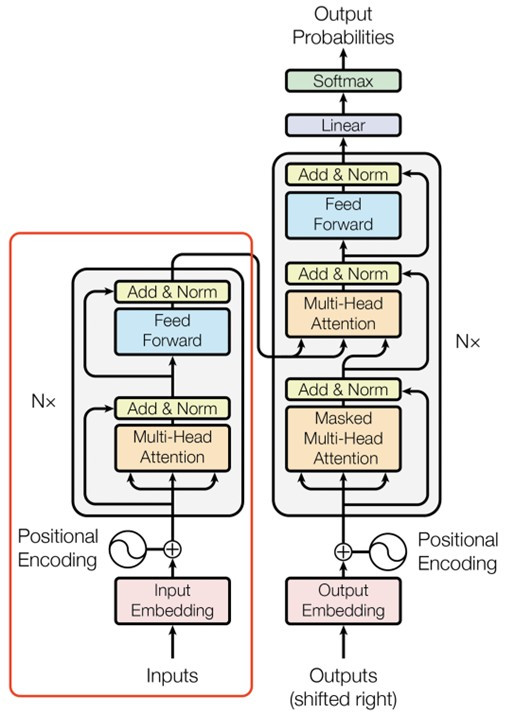

遷移式學習(Transfer Learning)

首先我們知道,在訓練神經網路後,網路會學習到許多特徵資料與權重,以CNN神經網路為例,在捲積層與池化層會做特徵強化與擷取特徵的動作,最後通過全連接層計算結果。而在遷移式學習中就是將擷取特徵(進入全連接層前的資料)提取出來,並且通過我們任務的需求,去微調這些特徵的權重也就是用前一個模型的特徵,來找到我們想要的結果。

預訓練模型

知道的遷移式學習的概念,是不是知道預訓練模型的名稱由來了?因為我們這個模型就被訓練過了,我們只需將這模型的特徵運用在我們的某層神經網路之內,或是對原始模型進行微調就能的到一個很好的結果。目前的預訓練模型分為兩種方式,分別是基於特徵(feature-based)與微調(fine-tuen)的方法。

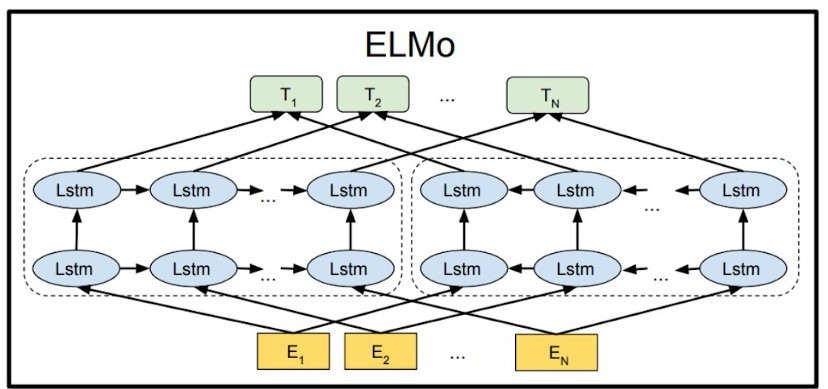

基於特徵(feature-based):這一種做法是使用一個經過大數據訓練過的模型結果(通常是特徵值),套入到模型的其中一層,並且通過自己的資料集,不斷的調整與學習資料。舉個例子在我們【day9】 讓電腦瞭解文字資料 & 使用Pytorch做IMDB影評分析中,使用到的神經網路embedding,在第9天我們是通過LSTM的文字前後關係,去更新embedding中的數值變化,若使用基於特徵的預訓練模型像是ELMO、Word2Vec,就能夠直接在embedding層當中導入這些已經被訓練好的特徵,這樣的效果就會比從0開始好非常的多。

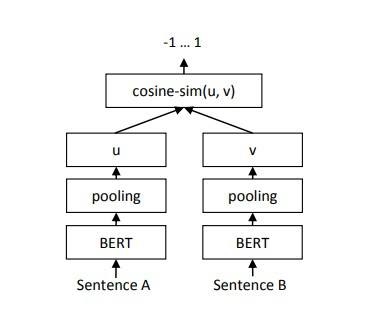

微調(fine-tuen):這種方法會保留原始模型,讓我們新增資料去調整這個原始模型各階層之間的權重,之後通過一個額外的接口(fine-tunr中主要是訓練這個接口),來實現各種不同的下游任務,使一個模型來完成多種不同的結果,例如:BERT可以做問答機器人,也可以做分類器,也就是因為這種特性,下游任務的寫法也成為了另一個議題。

1.實作辨識人臉

今天的目錄如下:

- 1.VGG-16介紹

- 2.下載資料與資料前處理

- 3.創建資料集

- 4.使用VGG-16模型並訓練

- 5.VGG-16完整程式碼

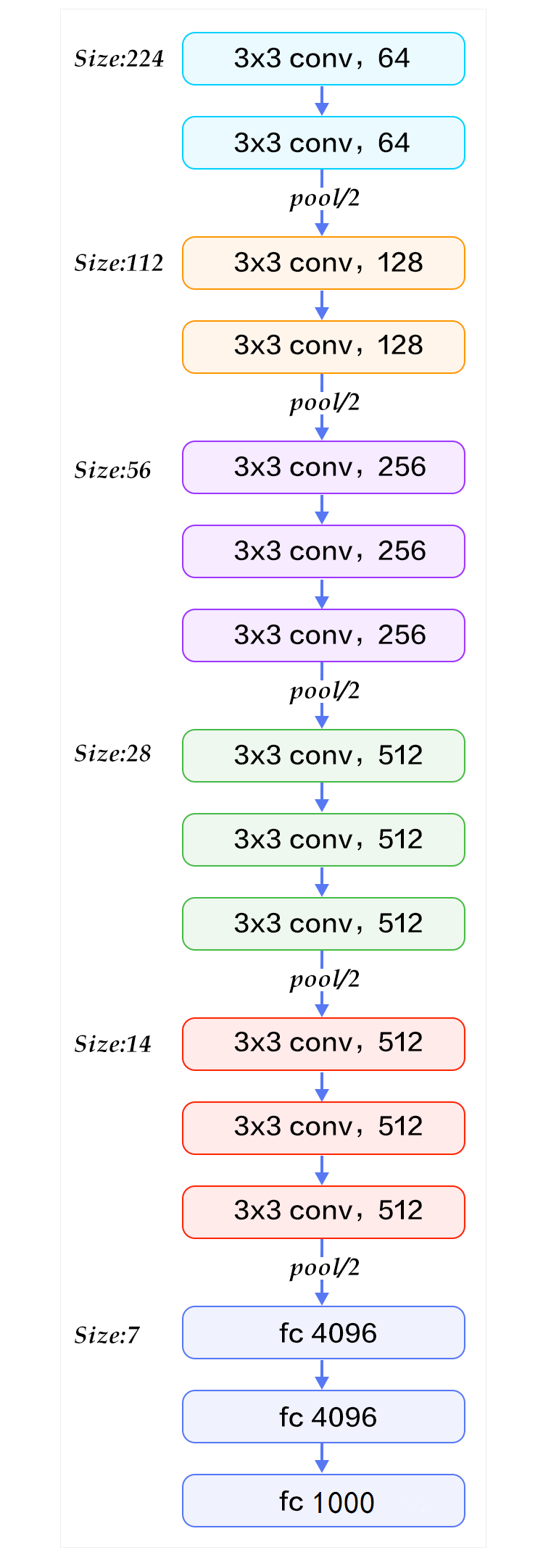

VGG-16簡介

在開始寫程式之前我們需要了解一下VGG-16內部構造。VGG-16最重要的概念就是使用大量的3x3捲積核來實現大捲積核的資料,例如:假設輸入為8、步長為1的CNN神經網路,5x5的捲積核最終輸出會是4(輸入-捲積核大小 + 1),而3x3的捲積核,使用兩次輸出結果也會是4(第一次8-3+1=6 第二次6-3+1=4),這代表一個5x5的捲積核可以通過2個3x3的捲積核來表達,這種做法的好處,就是在3x3中的捲積核保留了更多圖像的特徵值。

來源:http://deanhan.com/2018/07/26/vgg16/

可以看到在VGG16的架構圖中其實就是一個CNN的神經網路,但通過大量的數據與拆解捲積核的方式卻能大幅提升準確率

下載資料與資料前處理

瞭解到VGG16的構造後,就可以開始使用Pytorch實作了,首先為了辨識這個人到底是誰,我們還需要一筆資料,也就是別人的人臉資料,來區分我們需要點名的對象,我們可以先到kaggle下載這些人臉的資料點我下載。

之後我們創建以下的資料夾與檔案,並且開啟jupyter notebook來開始今天的實作 code └─data(放資料的資料夾) | ├─myface(放自己臉部的資料夾) | └─other(放剛剛下載的圖片的資料夾) └─VGG-16.ipynb(jupyter notebook的檔案)

import今天會用到的函式庫

import torch

import torch.nn as nn

import torch.optim as opt

import torch.nn.functional as F

import torchvision as tv

from torch.autograd import Variable

from torch.utils.data import Dataset, DataLoader,random_split

show = tv.transforms.ToPILImage()

接下來使用transforms.Compose()來創建要對圖片的操作,在這邊最重要的事情是我們需要將圖片縮放到224x224,因為這是VGG-16的輸入格式

transform = tv.transforms.Compose([

#轉成tensor格式

tv.transforms.ToTensor(),

#將短邊等比放大成224

tv.transforms.Resize(224),

#裁切多於的部分

tv.transforms.CenterCrop(224),

#正規化

tv.transforms.Normalize(mean=[0.5, 0.5, 0.5], std=[0.5, 0.5, 0.5])])

這樣就能完成資料前處理了

創建資料集

還記得前幾天最麻煩的事情嗎?就是使用class的方式建立dataset,在pytorch當中建立"圖片"的dataset其實很容易搞定,只需要將圖片放入到不同資料夾當中,就可以用tv.datasets.ImageFolder()一次性的將資料變成dataset,還能指定參數,去完成前處理的工作,這樣子做是不是能夠省下許多時間呢。

data = tv.datasets.ImageFolder('../data/',transform = transform)

train_num = int(len(data)*0.7)

test_num =len(data)-train_num

train_set, test_set = torch.utils.data.random_split(data, [train_num,test_num])

batch_size = 4

train_loader = DataLoader(train_set, batch_size = batch_size,shuffle = True, num_workers = 0)

test_loader = DataLoader(test_set, batch_size = batch_size, shuffle = True, num_workers = 0)

我們的資料變成dataset後會依照資料夾名稱排列來當作label,像是我們我們的兩個資料夾myface與other可以知道按照英文排序m比o還要早出現,所以myface的label就會為0,other就會是1,我們可以觀察一下的資料是否如同我們所想並且顯示照片。

#label轉換成名稱

classes = {0:'myface', 1:'other'}

#返回處理過後的圖片與label

img, label = data[2000]

顯示名稱

print(classes[label])

#還原正規化結果並顯示

show(img*0.5+0.5)

使用VGG-16模型並訓練

pytorch中可以通過tv.models.vgg16函式,下載VGG-16的預訓練模型,之後只需要設定好優化器與損失函數就能開始訓練了。

model = tv.models.vgg16(pretrained=True).cuda()

criterion = nn.CrossEntropyLoss().cuda()

optimizer = opt.Adam(model.parameters(), lr=0.0001)